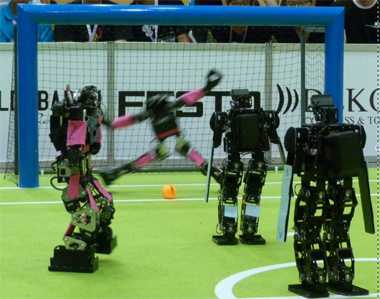

Die Angst des Roboters beim Elfmeter

Was Emotionen bei Robotern leisten sollen, ist ebenso umstritten wie die Frage, ob sie Gefühle benötigen, um intelligent zu sein

Brauchen Roboter Gefühle? Sicherlich nicht. Etliche Lebewesen können sich erfolgreich im täglichen Leben behaupten, ohne Gefühle bewusst zu erleben.

Obwohl Darwin bereit war, Insekten den Ausdruck von "Angst, Terror, Eifersucht und Liebe" einzugestehen, besprechen wir hier solche Gefühlszustände, die nicht rein physiologisch sind, sondern die auch als solche wahrgenommen werden. Ameisen z.B., obwohl sie soziale Insekten sind, empfinden wahrscheinlich nichts Besonderes, wenn sie die Brut pflegen oder Eindringlinge eifrig bekämpfen. Der Kopf einer Ameise lebt noch einige Minuten, nachdem er vom Körper abgetrennt wurde und greift sogar nach Nahrung, falls diese überreicht wird. Bei Reptilien ist es ebenfalls schwer vorstellbar, dass sie Kinder der Traurigkeit werden könnten. Fische haben Gesichter, die für uns Menschen fortwährend ausdrucklos bleiben. Erst bei Säugetieren, besonders bei Primaten, glaubt man so etwas wie höhere Gefühle beobachten zu können. Bei Affen bilden sie wichtige Elemente des Verhaltensrepertoires und bereits Darwin beschäftigte sich mit allgemeinen Prinzipien der Gefühlsausdrücke bei Menschen und Tieren, insbesondere bei Primaten.1 [1]

Emotionen und Science Fiction

Emotionen sind ein Standardmotiv der Roboterromane. In solchen Geschichten scheitern die intelligenten Maschinen der Zukunft an den verschiedensten Aufgaben, weil sie, anders als Menschen, bis zum bitteren Ende rein rational vorgehen möchten. Da, wo einfaches "common sense" oder Empathie notwendig gewesen wäre, um einen potentiellen Konflikt zu entschärfen, finden Maschinen mit ihren starren Algorithmen keinen Ausweg aus logischen Sackgassen.

Der Computer HAL in Clark und Kubricks Epos "2001: Odyssee im Weltraum" scheut nicht vor Mord zurück, um die ihm anvertraute Mission erfolgreich durchführen zu können. Gezwungen, die Raumfahrer zu belügen, um sie, koste es, was es wolle, zum Jupiter zu bringen, flüchtet sich der Rechner in eine Art zerstörerischen Wahnsinn. Allerdings ist seine Stimme immer neutral, sachlich und ausdrucklos. Das immer offene rote Auge verrät keine Emotionen. Erst als HALs Schaltungen ausgebaut werden, redet er offen über seine Angst:

Will you stop, Dave? Stop, Dave. I'm afraid. I'm afraid, Dave. Dave, my mind is going. I can feel it.

Auch Isaac Asimov hat sich bereits 1950 ausführlich mit dem Widerspruch zwischen reiner Rationalität und "common sense" auseinandergesetzt. In der Sammlung von Kurzgeschichten mit dem Titel "I, Robot" gibt jedes Kapitel ein neues Beispiel dafür, welchen Schaden inflexible Programmierung bei der Bewältigung von alltäglichen Aufgaben mit sich bringen kann.2 [2] Die Hauptfigur (neben dem Roboter selbst) ist eine Roboter-Psychologin, die in jedem Kapitel dem Scheitern und der kognitiven Fehlentwicklung der jeweiligen Roboter auf den Grund geht.

Emotionen scheinen deswegen etwas Besonderes zu sein: sie haben etwas mit höheren Intelligenzleistungen zu tun und obwohl wir Robotern eine gewisse Schlauheit zuschreiben könnten, ist es schwer vorstellbar, dass sie wie Menschen eines Tages auch emotional reagieren könnten. Die Frage ist dann, ob diese Roboter mit diesem Manko wirklich intelligent sein könnten. Marvin Minsky hat es 1985 auf den Punkt gebracht3 [3]:

The question is not whether intelligent machines can have emotions, but whether machines can be intelligent without any emotions.

Emotionen in der Robotik

Wenn Robotiker sich über das Thema Emotionen für Roboter oder Computer unterhalten, meinen sie nicht immer dasselbe. Es gibt zumindest drei mögliche Zugänge zu der Frage der Verarbeitung bzw. Berechnung von Emotionen:

- Roboter können Emotionen lesen. Ein Computer kann mit Hilfe einer Videokamera Gesichter von Menschen aufnehmen und aus den Bildern ermitteln, ob diese Menschen froh, frustriert oder gelangweilt sind. Schon lange redet man in der Informatik über "affective computing" und meint damit nicht, dass der Computer selbst Emotionen empfinden soll, sondern dass der Rechner seinem Gegenüber, dem Mensch, besser dienen kann, wenn sein Gemütszustand erkannt wird. Rosalind Picard hat bereits 1997 mit ihrem Buch über das Thema4 [4] die Grundlage dafür geliefert und gezeigt, dass Menschen in ihrer Interaktion mit Computern den Rechner quasi-sozial behandeln, und dass sie auch von dem Rechner "zivilisiertes" Verhalten erwarten. Softwarefirmen sind deswegen an "affective computing" erpicht. Nichts zieht die Aufmerksamkeit des Benutzers mehr an als ein Rechner, der sich wie ein Kumpel verhält, d.h. als perfekter Diener, der alle Wünsche erraten kann noch bevor diese ausgesprochen werden.

- Roboter können Emotionen vortäuschen. Einige Systemdesigner erhoffen sich eine höhere Akzeptanz von Robotern, wenn diese menschlicher auftreten, d.h. wenn sie nach außen gar nicht als Maschinen wirken. Da Menschen so gut beim Ablesen von Emotionen sind, ist es nicht schwer, ihnen Emotionen maschinell vorzutäuschen. Sogar eine Trickfilmzeichnung kann bereits die "Emotionen" der Trickfilmcharaktere transportieren. In Japan experimentieren Forscher seit Jahren mit Robotern, die Gesichtsausdrücke und andere Gesten imitieren und dadurch menschlicher erscheinen sollen. Einige Roboter ähneln automatisierten Wachsfiguren und mancher Roboterforscher hat sich bereits selbst als Roboter zumindest visuell geklont. Sehr erfolgreich sind auch die Experimente von Cynthia Breazeal und Rodney Brooks verlaufen, die mit minimalen Mitteln (ein robotisches Gesicht [5]) Menschen dazu gebracht haben, sich minutenlang mit Robotern zu unterhalten, obwohl diese nur ein paar Laute, je nach Kontext, von sich geben konnten und ansonsten nur neugierig geguckt haben.

- Roboter sollten Emotionen empfinden. Das ist eigentlich der heilige Gral bei vielen Forschungsprojekten. Praktisch jeden Monat erscheint ein Bericht in der Presse über einen Roboter, der diesmal "erstmalig" wirklich mit Menschen kommuniziert, Emotionen empfindet und ein echter Partner von Menschen sei. Könnte man aber wirklich solche Roboter bauen? Braucht man sie auch? Möchte man gelangweilte robotische Staubsauger haben, oder gar depressive, wie Marvin, der paranoide Roboter aus "Hitchhikers Guide to the Galaxy", der nicht einmal einen Bruchteil seiner Intelligenz braucht, um jegliche Aufgabe zu lösen?

Emotionen als physiologische Anspannung

Nicht nur Robotiker thematisieren Emotionen mehr und mehr. Neurobiologen und Kognitionswissenschaftler forschen schon lange über die biologische Notwendigkeit bzw. den Nutzen von Gefühlen, und auch über den Sitz derselben im menschlichen Gehirn. Heute, wo mit Hilfe von MRI (Magnetic Resonance Imaging) die Aktivierung von Gehirnarealen am Bildschirm verfolgt werden kann, ist es ein Leichtes, sich Experimente auszudenken, bei denen Hass- oder Liebeszentren erregt werden sollen (insofern es solche Zentren gibt). Fast jede Woche erfahren wir über neue "Sichtungen" von aktivierten Arealen bei den unterschiedlichsten Aufgaben. Emotionszentren werden dabei immer wieder ins Spiel gebracht, und auch wenn die Ergebnisse nicht immer vergleichbar sind, ja, obwohl sie sogar widersprüchlich sind, bieten sie einen ersten Einblick in die Verarbeitungsmaschinerie von Emotionen im menschlichen Gehirn.

Rein physiologisch gesehen, sind Emotionen chemische Vorgänge im Körper, d.h. Signalnetze. Bereits Pflanzen werfen chemische Signale in die Luft, um Nützlinge im Kampf gegen Schädlinge zu rekrutieren. Im Gehirn auch: Freude oder Angstzustände gehen Hand in Hand mit der Ausschüttung von Neuromodulatoren bzw. Hormonen, die erhöhte Aufmerksamkeit fordern oder den Körper auf die Flucht vorbereiten. Alle Federn werden chemisch angespannt und bereits ein kleiner Reiz kann als Auslöser wirken. Man kennt es vom Choleriker: Wenn das System einmal geladen ist, entlädt sich die Wut sehr schnell und praktisch unvermittelt.

Emotionen haben deswegen einen unmittelbaren physiologischen Nutzen. Droht Gefahr, ist es gut, sämtliche Reserven in Bewegung zu setzen, Adrenalin in die Blutbahn zu bringen und alle Muskeln anzuspannen. Geschieht dies dauernd, reden wir von Stress, der langfristig schädlich werden kann. Extreme Emotionen sind deswegen manchmal das allerletzte Mittel, um Gefahren auszuweichen oder ihnen zu begegnen.

Kurioserweise wird dieser Ansatz auch bei Maschinen verfolgt. Die Autoindustrie z.B. entwickelt sogenannte "pre-crash" Systeme, bei denen im Auto eingebaute Abstandssensoren eine mögliche Kollision innerhalb der nächsten zwei bis drei Sekunden erkennen und das Auto darauf "anspitzen". Dafür wird die Kraftverstärkung des Bremspedals angehoben, so dass bereits eine leichte Berührung des Fahrers ausreicht, um eine Vollbremsung einzuleiten. Damit wird wertvolle Zeit gespart, da die Elektronik das Auto eigentlich besser stoppen kann als der Fahrer selbst. Gleichzeitig bleibt die Verantwortung und Haftung beim Fahrer, da dieser ja selbst gebremst hat. Wenn man so will, hat sich das Auto "erschreckt" und reagiert beim Bremsvorgang empfindlicher.

Emotionen als Heuristik

Antonio Damasio ist der Neurobiologe, der vielleicht am intensivsten von Robotikern gelesen wird. Das liegt einerseits daran, dass seine Aufsätze dem allgemeinen Publikum zugänglich sind, aber auch daran, dass die Hauptthesen von "Descartes Error" besonders relevant für die Künstliche Intelligenz sind.5 [6]

Damasio postuliert in seinem Buch, dass es eine enge Verbindung zwischen Emotionen und Entscheidungen gibt. Personen, bei denen Gehirnareale geschädigt wurden, die Emotionen verarbeiten, scheinen nicht in der Lage zu sein, "ökonomisch" für sich vorteilhafte Entscheidungen treffen zu können. Bei Spielen, in denen sie die falsche Strategie verfolgen, sind sie z.B. nicht in der Lage, diese zu ändern - auch wenn sie im Spiel dafür mehrmals bestraft werden. Der eingegangene Verlust tut nicht weh und führt nicht zur Verhaltensänderung. Sie merken nicht, dass es günstigere Alternativen gibt.

Nach Damasios Urteil weisen Emotionen blitzschnell gewissen Entscheidungen eine Bewertung zu, bevor der deliberative Teil des Gehirns mit dem "number crunching" anfängt, d.h. mit der Abwägung aller möglichen Pros und Contras. Die Reduktion auf eine Handvoll möglicher Alternativen verhindert Unentschlossenheit. Man kennt es aus Experimenten im Supermarkt mit vielen Produkten: Dort, wo die Auswahl reichhaltiger ist, können sich die Kunden schwerer entscheiden und kaufen letztendlich weniger. Dies nennt man "choice overload".6 [7]

In der KI-Forschung kennt man seit Jahrzehnten den Wert von Heuristiken. Aus Spaß redet man vom Beispiel des Roboters, der eine Bombe entschärfen soll, und regelmäßig daran scheitert, dass er zu lange überlegt. Auf der Suche nach dem optimalen Abschaltvorgang wird der gesamte Entscheidungsbaum im Computer mühsam durchschritten, weil der Roboter einfach keine Eile kennt. Emotionen könnte man deswegen als "shortcuts" für schnelle, obwohl suboptimale, Entscheidungen verstehen, die eine Reaktion in Echtzeit ermöglichen. Heuristiken liefern auch in vielen Fällen Lösungen, die nicht sehr weit vom Optimum liegen.7 [8]

Insekten brauchen dkeine Emotionen, weil sie fast wie Roboter aufgebaut sind, d.h. zum Teil rein reaktiv. Die Flugmuskeln einer Fliege haben z.B. eine direkte Verbindung zu den neuronalen Kreisen in den Augen, die den optischen Fluss verarbeiten.

Bewegt sich die Welt im linken Auge schneller als im rechten, dann befindet sich die Fliege näher zu Hindernissen links als zu Hindernissen rechts. Eine Drehung nach rechts wird dann direkt von dem Flugmuskel und ohne Intervention des Gehirns eingeleitet - und so bleibt die Fliege beim Fliegen im Tunnel wohlzentriert. Auch der Flugreflex der Fliege ist gut bekannt: Hält man eine Fliege mit einer Pinzette hoch, fängt diese sofort an, mit den Flügeln zu schlagen. Die Flugmuskulatur "weiß", dass in Abwesenheit von Bodenkontakt sofort das Fliegen "eingeschaltet" werden muss. Bei Insekten gibt es, wie man sieht, eine direkte und unmittelbare sensomotorische Kopplung. Insekten tun, was sie direkt messen, sie sind voll reaktive Systeme.

Je höher wir im Lebensreich aufsteigen, desto intelligenter werden die Tiere und desto weniger rein reaktiv ist ihr Verhalten. Der Prozess ist jedoch nicht binär, es gibt kein Schwarz oder Weiß. Von den Insekten zu den Reptilien, kleinen Säugetieren, Vögel und schließlich Primaten bietet sich ein Kontinuum an Intelligenz an - und parallel dazu eine graduelle Überlagerung des rein reaktiven mit dem deliberativen Verhalten.

Wir Menschen sind selbst Tiere und diese reaktive Historie haben wir in unserem Körper auch materialisiert vorgefunden. Ich rede dabei nicht von den basalen physiologischen Vorgängen, wie dem Herzschlag oder dem Atmen, Vorgänge, bei denen wir uns wie reine Automaten verhalten, sondern über höhere kognitive Leistungen. Sogar beim Sehen verhalten wir uns reaktiv: unsere Augen springen unwillkürlich da hin, wo sich etwas bewegt. Wir glauben, dort Gesichter zu sehen, wo es keine gibt, in Bäumen oder Wolken. Sämtliche optischen Illusionen beruhen darauf, dass wir nicht nur sehen, sondern dass unser Gehirn unbewusst immer etwas sehen will.

Reaktive Emotionen und Spiegelneuronen

Jeder kennt das Gefühl: Wird ein Mensch geschlagen, zuckt man sofort und spürt den Schlag auf dieselbe Stelle. Verbrennt sich jemand einen Finger, greifen wir unwillkürlich nach unserer Hand. Empathie ist deswegen etwas sogar Körperliches, Somatisches: Wir spüren, was unser Gegenüber spürt. Diese Beispiele von Empathie lassen sich auf Emotionen übertragen: Die Freude der anderen macht uns froh, ihre Tränen stimmen uns traurig.

In der Neurobiologie wird seit mehr als 16 Jahren über die evolutive Rolle von Spiegelneuronen diskutiert. Diese "mirror neurons" wurden so benannt, weil sie im Gehirn von Affen feuern - sowohl, wenn eine Aktion vom Affen selbst ausgeführt wird (z.B. eine Nuss mit dem Finger nehmen), als auch, wenn der Affe jemand Anderen bei derselben Aktion sieht. Nach der Deutung der Spiegelneuronen-Forscher bilden wir den Körper des Anderen in unserem Körper ab, so dass es einfacher ist, die Handlungen des Anderen zu verstehen.8 [9] Wir brauchen keine verdoppelten neuronalen Schaltungen, um Arme zu bewegen und gleichzeitig Armbewegungen eines Anderen zu begreifen. Beides wäre, neuronal gesehen, ein und dasselbe.

Paradoxerweise sind Spiegelneuronen bei Robotikern mittlerweile populärer als bei Neurobiologen. Bei den Biologen scheint die Diskussion über die Spiegelneuronen keineswegs abgeschlossen zu sein.9 [10] Es wird immer noch viel über das neuronale Substrat und über die physiologische Bedeutung debattiert. Das Problem ist, dass Spiegelneuronen sehr verbreitet zu sein scheinen, aber gleichzeitig zu unspezifisch sind. Bei Robotikern dagegen ist die Strategie, "Spiegelneuronen" im Roboterkörper einzuprogrammieren, ein mögliches Paradigma, um Perzeption mit Kognition zu verbinden. Kurz gesagt: Ein Roboter, der eine Aktion beobachtet, kann diese auf den eigenen "Motoren" abbilden und dann überprüfen, welche Aktion gerade ausgeführt wurde. Dazu braucht man eine Art große Korrespondenztabelle von Motorwerten auf Handlungen.

Im Fall von Emotionen könnte ein Roboter lernen, diese durch die Aktivierung von bestimmten Muskeln im künstlichen Gesicht synthetisch zu erzeugen. Emotionen von Menschen könnten dann durch die Abbildung der Gesichtsmerkmale des Gesprächspartners auf die eigenen vorprogrammierten künstlichen Ausdrücke decodiert und so verstanden werden. Das Ganze wäre völlig reaktiv und der "emotionale" Roboter wurde uns rundweg täuschen können, obwohl er so wenig Emotionen wie eine Fliege beim Flug empfinden würde.

Evolutiver Wert der Emotionen

Wahrscheinlich kann ein Wesen nur echte Angst oder Freude empfinden, wenn diese das Produkt der Evolution sind, d.h., wenn es wirklich um Leben oder Tod geht. Ein Computerprogramm ist unsterblich. Der Computer kann ja jedes Mal neu gestartet werden, sogar dann, wenn das Programm fehlerhaft ist. Die Software eines Roboters kann auf einen anderen Roboter kopiert werden. Wenn wir Menschen (so wie die Software) "neu zu booten" wären, wären wir dann nicht unberechenbar und allzu risikofreudig? Unsterblichkeit würde jegliche Angst auslöschen.

Lebewesen sind in einem langen Evolutionsprozess entstanden. Bei eher reaktiven Lebewesen, die eine Aktion nicht lange überlegen, sind Emotionen wahrscheinlich in nuce vorhanden (als chemische Vorgänge) und daher rein mechanische, nicht der Introspektion zugängliche Ereignisse. Jemand hat gesagt, Insekten erleben einen Film nicht als Historie und Dynamik, sondern Bild für Bild. Ameisen können auch keine Verletzung beklagen, da ihnen den Begriff des Selbst fehlt.

Ab welcher kognitiven Stufe sind also Emotionen notwendig? Folgende Antworten wären plausibel: a) Sozialität braucht Emotionen, und b) komplexe intelligente Systeme brauchen sie ebenfalls.

Was Sozialität betrifft, ist es interessant anzumerken, dass Säugetiere sich von Reptilien deutlich beim Schutz der eigenen Nachkommen unterscheiden. Vom evolutiven Standpunkt aus ist es wahrscheinlich günstiger, den Nachwuchs zu schützen und zu pflegen, als diesen zu vernachlässigen (oder gar kannibalisch zu verschlingen), so dass die eigenen Gene maximale Verbreitung erfahren.

In Bezug auf die Komplexität der kognitiven Systeme ist es wahrscheinlich besser, wenn sie mehrstufig aufgebaut sind. Bei Menschen z.B. erfüllt der Cortex kognitive Aufgaben und bewältigt vielschichtige Probleme. Vorgänge im Körper, die eher reaktiv behandelt werden, können zu einem "kleinen Hirn" ausgelagert werden. Daraus ergibt sich eine doppel- oder dreistufige Kontrollarchitektur. Es ist nicht lange her, dass für das menschliche Gehirn eine solche dreistufige Einteilung vorgeschlagen wurde: Das Kleinhirn steuert die physiologischen Vorgänge, das limbische System steuert die Emotionen (Flucht oder Kampf), während der Neocortex (auf beide andere Stufen daraufgesetzt) höhere kognitive Aufgaben übernimmt.

Auch wenn die Neurobiologen dieser schematischen Teilung des Gehirns nicht unbedingt zustimmen und obwohl das Ganze sicherlich komplizierter ist (da die Evolution nicht jedes Mal von vorne anfängt und immer auf bereits vorhandene Strukturen zurückgreift), ist diese Dreiteilung von bestechender Einfachheit. Für Roboter übersetzt würde das bedeuten, dass eine Kontrollarchitektur sich aus folgenden wesentlichen Bestandteilen zusammensetzen lässt:

- Kognitive Module für Planen, Erkennen, und Semantik.

- Heuristiken als Shortcuts für schnelle provisorische Bewertungen

- Reaktives Verhalten für die sensomotorische Kopplung, sowie Steuerung von Bewegung und motorischen Lernprozessen.

Denkbar wäre, die drei Module auf unterschiedlicher Hardware laufen zu lassen, die verschieden schnell und zuverlässig sein kann. Die reaktive Steuerung z.B. sollte nie ausfallen bzw. sollte sie sich innerhalb von Mikrosekunden erholen können, während der kognitive Teil komplexitätsbedingt nicht immer Antworten in Echtzeit liefern kann und auf komplexerer Hardware läuft. Das limbische System kann zwischen beiden Ebenen vermitteln und das Gesamtsystem zu einem sicheren Zustand führen, auch wenn von oben noch kein Befehl vorliegt.

Für den Fall eines autonomen Fahrzeugs z.B. könnte die reaktive Komponente aus einem Mikrokontroller bestehen, der zuverlässig und mit minimaler Ausfallzeit das Fahrzeug immer in eine sichere Lage bringt. Die Firma BMW z.B. forscht an kleinen Rechnern, die das Fahrzeug zum Stillstand bringen, auch wenn der Fahrer gerade einen Herzinfarkt erlitten hat. Einen solchen Software-Infarkt könnten auch die "kognitiven" Navigations- und Steuerungsmodule erleiden und auch in diesem Fall sollte das Gesamtsystem weiter zuverlässig arbeiten können.

Diese mehrstufige Architektur für robotische Systeme erinnert an die Cerebellum-Struktur des Gehirns und erfüllt eine ähnliche Funktion. Das "limbische" System ist in dem Fall nur der Sitz der Heuristiken, aber auch der Sitz der möglichen Modulation von Aktuatoren, so dass das Gesamtsystem bei möglichen Problemen im Voraus "angespannt" wird. Die Pre-Crash-Bremsung, die vorher beschrieben wurde, könnte bereits an dieser Stelle vorbereitet werden, so dass vom kognitiven Teil nur eine Bestätigung kommt, aber der Prozess im Grunde schon erwartet und angeleitet worden ist.

Emotionen als Entstehungsprozess

Es ist die Überzeugung von Forschern wie Rodney Brooks, dass maschinelle Intelligenz nicht von oben nach unten, sondern nur von unten nach oben entstehen kann.10 [11] Dies bedeutet, dass zuerst die reaktiven Fähigkeiten entwickelt werden, d.h. die Basisfunktionalität bereitgestellt wird, und erst dann, in Interaktion mit der Umwelt, die restlichen Fähigkeiten nach und nach draufgesetzt werden. Für die Robotik übersetzt, würde dies bedeuten, dass man aus der Roboterfabrik keine fertigen Intelligenzen liefert, sondern Maschinen, die erst im Lernprozess ihre Wirksamkeiten entdecken und sie voll entfalten. Statt einen neuen Laufroboter mühevoll zu messen und zu kalibrieren, würde sich dieser langsam bewegen und seine optimalen Bewegungsmuster nach vielen Einzelversuchen autonom finden können. Intelligenz ohne Lernen gäbe es also nicht.

Es ist gerade diese Interaktion mit der Umwelt, die die Möglichkeit des Scheiterns und des "Ablebens" darstellt. Systeme, die sehr lange brauchen, um mit der Welt zurechtzukommen, würden ständig scheitern. Es wäre also denkbar, zwei Arten von Lernprozessen zu haben: Sehr basale, die sich eher auf die Motorik und Sensorik des Roboters beschränken, auf den Schutz ihrer Teile und auf schnelle Reaktionen. Ein zweiter Lernprozess würde die Reichhaltigkeit der sensorischen Erfahrungen analysieren, auseinandernehmen und Schlussfolgerungen daraus ziehen. Dass man, wenn man sich die Hand verbrennt, diese zurückzieht, lernt man im unteren Lernprozess. Dass ein Ofen brennen kann, lernt man im oberen Lernprozess. Die von Robotern selbst gelernten Heuristiken, die shortcuts ("bei starkem Wärmesignal Hand präventiv zurückziehen"), könnten als künstliche Emotionen gedeutet werden.

Emotionen sind etwas Subjektives, etwas, das nur jeder für sich erfahren kann. Sie sind noch subjektiver als Farbempfindungen, die häufig von Philosophen als Paradebeispiel für Subjektivität angeführt werden. Ohne Subjekt keine Subjektivität. Ohne Roboter, die sich selber als denkende Wesen verstehen, kein Subjekt. Ohne Evolution und ohne Kampf ums Dasein kein Selbst. Emotionen können nicht einprogrammiert werden, sie können nur autonom, d.h. emergent, zufällig, und sozusagen nebenbei entstehen.

Es mag deswegen überflüssig erscheinen über die Frage von Emotionen in Robotern nachzudenken, wäre es nicht so, dass jedes Jahr ein neuer Roboter "mit Emotionen" durchs globale Dorf getrieben wird. Dazu kann es nach dem heutigen Stand der Technik nicht einmal in den nächsten hundert Jahren kommen - und womöglich nie. Dafür müssten die Roboter praktisch den Grad der Komplexität von Lebewesen erreichen. Es ist fraglich, ob es mit mechanisch-elektronischen Mitteln gelingen kann, etwas Besseres zu bauen als das, was die Natur mit biologischem Material in Jahrmillionen erschaffen hat. Denn denkende Roboter gibt es bereits: Das sind wir.

Um zum Anfang zurückzukommen: Ein Fußballroboter besäße erst Emotionen, wenn er als Torwart beim Elfmeter vor Furcht und Erregung zittern würde. Das würde aber voraussetzen, dass dieser Roboter sich als Individuum begreift, als einer, der morgen ohne Job auf dem Regal von Ersatzteilen enden könnte. Erst dann könnten Roboter emotional agieren und sich sogar Gedanken über ein Leben nach dem Tod machen. Manche haben sich ja bereits die Frage nach der Beziehung zwischen Religion und Robotik gestellt.11 [12] Solche Roboter wären dann wirklich intelligent und wir würden ihnen gerne einen Platz im Roboterhimmel zugestehen.

Rául Rojas lehrt Künstliche Intelligenz am Institut für Informatik [13] und am Dahlem Center for Intelligent Systems an der Freien Universität Berlin.

URL dieses Artikels:

https://www.heise.de/-3390758

Links in diesem Artikel:

[1] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_1

[2] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_2

[3] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_3

[4] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_4

[5] http://news.bbc.co.uk/local/threecounties/hi/people_and_places/newsid_8900000/8900417.stm

[6] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_5

[7] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_6

[8] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_7

[9] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_8

[10] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_9

[11] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_10

[12] https://www.heise.de/tp/features/Die-Angst-des-Roboters-beim-Elfmeter-3390758.html?view=fussnoten#f_11

[13] http://www.inf.fu-berlin.de/groups/ag-ki/index.html

Copyright © 2011 Heise Medien