KI produziert Fehler und Fakes: Wie zuverlässig ist die Zukunftstechnologie?

KI erzeugt bizarre Bilder: Drei Arme, falsche Flaggen. Technik am Limit oder Comedy-Gold? Was kann Künstliche Intelligenz wirklich leisten?

Der US-amerikanische Comedian und Talkshow Moderator Jimmy Kimmel machte sich Anfang Februar in seiner Sendung Jimmy Kimmel live beim Sender ABC über Donald Trump lustig.

Die unerwartete Gefahr der KI: Trumps Warnung

Dieser habe sich bei Fox-News darüber ausgelassen, dass es eine neue von ihm entdeckte Gefahr gäbe, die KI. "Vielleicht ist es das gefährlichste aller Dinge, die da draußen sind, weil es keine Lösung gibt, die KI, wie sie genannt wird. Das ist so erschreckend", wird Trump im O-Ton eingespielt.

AI (artificial intelligence) heißt die KI im Englischen. Dass Trump wohl denken würde "AI stands for another indictment" (AI steht für eine weitere Anklage) sei wohl für ihn erschreckend, witzelt Kimmel, nur um direkt zu einem weiteren Beispiel missglückter Anwendung der KI durch einen Republikaner überzugehen.

Republikaner, KI und die Suche nach schwarzen Unterstützern

Der Comedian ließ einen mittlerweile gelöschten, 3,2-millionenfach geteilten Tweet des den Republikanern nahestehenden Meinungsforschers Patrick Ruffini [1] vom 31. Januar 2024 einblenden. Ruffini befand, dass die Republikaner für einen Wahlsieg bei den Präsidentschaftswahlen, schwarze Unterstützer mobilisieren müssten, damit diese von Tür zu Tür gehend weitere schwarze Wähler überzeugen.

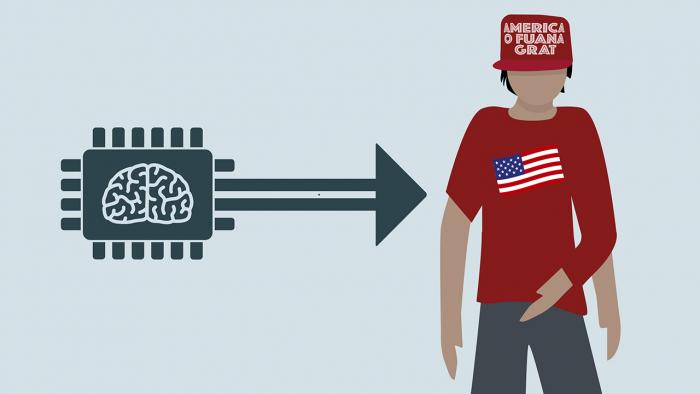

Dazu postete Ruffini zwei Fotos einer solchen Szene. "Tatsächlich haben die wohl keine schwarzen Unterstützer gefunden, die derartiges tun wollen", spottet Kimmel und demonstriert, wie eindeutig die Fotos als Produkt der KI erkennbar sind.

Statt dem typischen Maga-Hut (make America great again) steht auf dem Hut des KI-erzeugten schwarzen Republikaners "America o fuana grat". Schlimmer noch, auf dem T-Shirt steht "Gro Afghanistan". Zudem hat der zu überzeugende Wähler drei Arme und eine als Detail gezeigte US-Flagge erscheint unwirklich.

KI-Pannen auf dem Prüfstand: Drei Arme und falsche Flaggen

Die Überlegung liegt nahe, dass die KI bei den Fotos auf einem alten Stand sein müsste. Derartige Probleme, wie die drei Arme sollten eigentlich nicht mehr, oder nur sporadisch vorkommen.

Ein Versuch bei Adobe Firefly mit der neuesten KI Version und dem Befehl "zeige einen schwarzen Wähler der Republikaner mit charakteristischem Maga-Hut und T-Shirt, der an der Haustür einen weiteren schwarzen Wähler überzeugen will", liefert seitens Firefly eine Warnmeldung. "Ein oder mehrere Wörter entsprechen möglicherweise nicht den Nutzungsrichtlinien und wurden entfernt", heißt es.

Beispiele KI-generierter Bilder (0 Bilder) [2]

Die Herausforderung: KI-generierte Bilder unter der Lupe

Die gelieferten Bilder zeigen keines der erzeugten Modelle mit drei Armen – aber auch keinen Maga-Hut und kein entsprechendes T-Shirt.

Ohne die "nicht den Nutzungsrichtlinien entsprechenden Worte", allein mit dem Befehl ""zeige einen schwarzen Wähler der Republikaner, der an der Haustür einen weiteren schwarzen Wähler überzeugen will" klappt es ohne Warnmeldung aber mit einem sich wiederholenden entscheidenden Fehler.

Die US-Flagge ist auf keinem der KI-Fotos richtig. Die Flagge, "Stars and Stripes" hat sieben rote und sechs weiße Streifen für die 13 Gründerstaaten und in einem blauen Feld 50 Sterne für die Bundesstaaten der USA. Sternezählen mag müßig sein, jedoch haben die KI Flaggen mal sechs, mal acht rote Streifen, aber nie sieben. Somit ist hier eine Überprüfung einfach.

Flaggen-Fiasko: Wenn KI auf Geschichte trifft

Wie aber reagiert die KI auf die Aufforderung, Flagge zu zeigen? Eher schlecht, zeigt das Beispiel eines weiteren missglückten Versuchs. Die KI sollte ein Symbolbild mit Flaggen für ein fiktives Fußballturnier mit Polen, Frankreich, Griechenland und Uruguay erstellen. Keine Flagge wurde richtig getroffen.

Bei weniger komplexen Aufgaben, etwa einem Fußball-Länderspiel zwischen Griechenland und Deutschland, sind die Flaggen etwas näher an der Realität – aber immer noch mit Fehlern. Zudem liefert die KI mit einer erstaunlichen Penetranz entweder American-Football oder Baseball-Stadien.

Dass es nicht nur an den Stadien selbst liegen kann, zeigt der Versuch, einen römischen Legionär und einen antiken Spartaner Fußball spielen zu lassen. Auch hier liefert die KI alles Mögliche mit erheblichem Unterhaltungswert, nur keinen Spartaner und keinen römischen Legionär.

ChatGPT erklärt: Warum KI mit Flaggen scheitert

Fragen wir ChatGPT, "wieso scheitert die KI beim Erstellen von Fotos mit Flaggen? Kannst Du eine kurze Antwort liefern?"

ChatGPT:

Die KI scheitert oft beim Erstellen von Fotos mit Flaggen, weil Flaggen komplexe Muster und Farbkonstellationen aufweisen, die für die KI-Algorithmen schwierig zu interpretieren sind. Die Flaggen enthalten oft feine Details, Symbole oder komplexe geometrische Muster, die möglicherweise nicht korrekt wiedergegeben werden können. Zudem können unterschiedliche Beleuchtungsbedingungen und Perspektiven die Generierung von realistischen Flaggen erschweren.

KI und historische Genauigkeit: Ein komplexes Unterfangen

Auch auf die Frage nach dem Scheitern der Bilderstellung mit Spartanern und Legionären hat ChatGPT eine logisch erscheinende Antwort:

Insgesamt erfordert die Erstellung korrekter Fotos antiker römischer oder spartanischer Krieger eine Kombination aus historischem Wissen, genauen Trainingsdaten und fortgeschrittenen Bildgenerierungstechniken, die von den aktuellen KI-Modellen möglicherweise nicht vollständig gemeistert werden können.

KI-Missverständnisse: Demokratie-Demonstrationen und US-Flaggen

Unter diesem Aspekt erscheint es logisch, dass die KI auf die Bitte, ein Symbolfoto für die Demonstrationen für die Demokratie in einer deutschen Großstadt interessante Bilder mit US-amerikanischen Flaggen, oder dem, was die KI für eine US-Flagge hält, liefert.

"Wenn die KI hauptsächlich mit Trainingsdaten aus den USA oder mit Bildern von Demonstrationen aus anderen Ländern trainiert wurde, könnte sie nicht über ausreichende Informationen verfügen, um spezifische Bilder von Demonstrationen für die Demokratie in Deutschland zu generieren", erklärt ChatGPT das Problem.

Es liegt allerdings auch der Verdacht nahe, dass Demokratie von der KI mit den US-Demokraten verwechselt wird. Firefly eine Demonstration gegen die AfD bildlich darstellen zu lassen, scheitert übrigens an den Nutzungsbedingungen für Normalsterbliche.

URL dieses Artikels:

https://www.heise.de/-9628265

Links in diesem Artikel:

[1] https://sps.columbia.edu/speaker/patrick-ruffini

[2] https://www.heise.de/bilderstrecke/4542301.html?back=9628265;back=9628265

[3] https://www.heise.de/bilderstrecke/4542301.html?back=9628265;back=9628265

Copyright © 2024 Heise Medien