Überlegungen zu moralischen und unmoralischen Maschinen

Neben die Moralphilosophie als Menschenethik ist im 21. Jahrhundert die Maschinenethik getreten

Seit zweieinhalbtausend Jahren treiben die Menschen philosophische Ethik. Das Werk von Aristoteles in der griechischen Antike bildet einen ersten Höhepunkt. In der deutschsprachigen Philosophie trägt Immanuel Kant ebenso Entscheidendes bei wie Arthur Schopenhauer, der in seiner normativen Ethik auch das Tier erfasst, mit Hilfe des Mitleids. Der Engländer Jeremy Bentham, Begründer des Utilitarismus, stellte einen anderen Tatsachenverweis in den Mittelpunkt seiner Überlegungen, das Leid bzw. das Leiden. Entscheidend sei nicht, ob etwas denken oder sprechen, sondern ob etwas leiden könne. Das half wiederum dem Tier, zumindest in der Theorie.

Neben der Moralphilosophie mit ihren wissenschaftlichen Methoden (wie der logischen, diskursiven und dialektischen Begründung) haben sich im Laufe der Zeit noch andere Zugänge herausgebildet, etwa Moraltheologie und Moralökonomie. Während die eine keinen wissenschaftlichen Anspruch erheben kann, da eine Grundanforderung verletzt wird, das Absehen von Autoritäten in letzter Instanz sowie Voraussetzungslosigkeit und Vorurteilsfreiheit, ist die andere zwar in manchen Fragen befangen, aber nicht bei allen Antworten in ihrer Marktgläubigkeit, die man in ihren Ansätzen erkennen mag, gefangen. Neben die Moralphilosophie als Menschenethik ist im 21. Jahrhundert die Maschinenethik getreten.

Die Maschinenethik hat die Moral von Maschinen zum Gegenstand, vor allem von (teil-)autonomen Systemen wie intelligenten Agenten, bestimmten Robotern, bestimmten Drohnen und selbstständig fahrenden Autos (Bendel 2012). Aus ihrer Perspektive werden Maschinen zu Subjekten der Moral, wobei die Vertreter durchaus betonen, dass es ganz neuartige, merkwürdige Subjekte sind, und versuchen, die "moral agents" zu kategorisieren und zu relativieren.

Ob die Maschinen Objekte der Moral sind, ob sie z.B. bestimmte Rechte haben, versucht man schon seit der Mitte des 20. Jahrhunderts zu klären, innerhalb der Künstlichen Intelligenz (KI) oder der Robotik – oder in der Disziplin der Roboterethik, die zwar auch als Teilgebiet der Maschinenethik verstanden werden kann, aber vor allem auf die Verwendungsweisen und deren Auswirkungen sowie die Rechte der Roboter in moralischer Hinsicht zielt. Nicht nur die möglichen Rechte, auch die möglichen Pflichten, Verpflichtungen oder Verantwortlichkeiten von Systemen wurden schon lange vor dem Entstehen der Maschinenethik als Disziplin thematisiert (Bechtel 1985; Snapper 1985).

Die Maschinenethik wird im vorliegenden Text als Pendant zur Menschenethik angesehen (Bendel 2014). Sie kann ebenso innerhalb von Informations- und Technikethik eingeordnet, also als Bereichsethik und damit als Teil der Menschenethik eingestuft werden. Die angewandte Ethik war bisher Menschenethik, von menschlichen Subjekten der Moral ausgehend und – bis auf die Tierethik und allgemeiner die Umweltethik, die wiederum die Wirtschaftsethik beeinflussen – in erster Linie auf menschliche Objekte der Moral bezogen. Man kann insgesamt sagen, dass die Ethik stets anthropozentrisch war, und wer Moral für etwas zutiefst Menschliches hält, wird dies als schiere Selbstverständlichkeit deklarieren.

Zu den Hauptwerken der Maschinenethik im engeren Sinne (die Vorarbeiten und Strömungen der Roboterethik außer Acht lassend) können "Moral Machines" (2009) von Wendell Wallach und Colin Allen, "Machine Ethics" (2011) von Michael Anderson und Susan Leigh Anderson (als Herausgebern) sowie "Programming Machine Ethics" (2016) von Luís Moniz Pereira zählen. Zu beachten ist, dass die strikte Trennung zwischen Ethik und Moral, die in der deutschsprachigen Philosophie und überhaupt Wissenschaft üblich ist, im englischsprachigen Raum nicht immer besteht und "machine ethics" sowohl die Disziplin als auch ihren Gegenstand bezeichnen kann. Ich habe in den letzten Jahren, der hiesigen Tradition folgend, eine Etablierung des deutschen Begriffs im Sinne der Disziplin versucht. Am Rande sei bemerkt, dass in unserer Sprache zwischen "Moral" und "Moralität" unterschieden wird, was im Englischen nicht einfach abzubilden ist. Man darf freilich die Moralität, den Willen zum Guten, der Moral gleichsam anhängen und aus verschiedenen Gründen die entsprechende Diskussion ausblenden.

Maschinelle Moral

Die Ethik ist also die Disziplin, die Moral ihr Gegenstand. Ein Student von mir erklärte während einer Vorlesung auf Nachfrage treffend: Ethik treibt man, Moral hat man. Was ist nun aber die Moral, was ist das, was man hat, als Jugendlicher oder Erwachsener, als Person? Es gibt unterschiedliche Erklärungsversuche von verschiedenen Philosophen. Man kann, Otfried Höffe folgend, von einem normativen Grundrahmen für das Verhalten vor allem zu den Mitmenschen, aber auch zur Natur und zu sich selbst sprechen, von einem Komplex von Handlungsregeln, Wertmaßstäben und Sinnvorstellungen. Wenn wir etwas als moralisch bezeichnen, meinen wir häufig, es sei moralisch gut, und wenn wir etwas als unmoralisch bezeichnen, finden wir es moralisch schlecht.

Der Begriff der maschinellen Moral wird von einigen Vertretern verwendet wie der Begriff der künstlichen Intelligenz, entweder metaphorisch oder intentional. In diesem Sinne würde man zum einen die maschinelle Moral mit der menschlichen Moral nicht oder nicht in allen Aspekten gleichsetzen, sondern sie mit dieser in ein Verhältnis setzen; diese wäre ein Vorbild und jene ein Bild von ihr, eben eine mehr oder weniger stimmige Metapher (und mithin ein Bruchstück oder eine Spielart). Man könnte zum anderen annehmen, dass dieses Vorbild in ferner Zukunft erreicht wird, dass die maschinelle Moral eines Tages nicht mehr unterscheidbar von der menschlichen oder dieser zumindest sehr ähnlich ist; dann hätte man eben eine Intention, die man mit dem Begriff der maschinellen Moral andeutet.

Vor diesem Hintergrund halte ich es für unproblematisch, von moralischen Maschinen zu sprechen. Ich meine eben nicht, dass diese identisch mit moralischen Menschen seien, weder mit Blick auf die Moral noch in Bezug auf die Verstandes- bzw. Gefühlsfähigkeit. Sie sind für mich selbst dann nicht identisch, wenn ausschließlich menschliche Moral übertragen und ausgeführt wird, denn die maschinelle Moral ist dennoch anders, und die Regeln und Fälle, die der Mensch eingespeist hat, passen selten ganz genau zu den tatsächlichen Situationen, und die erdachten und die tatsächlichen Situationen liegen meist leicht verrutscht übereinander. Die teilautonomen und autonomen Maschinen, die ohne uns zurechtkommen müssen, auf den Straßen, über den Wäldern, über den Meeren, wenden Regeln und Fälle nicht nur raum- und zeit-, sondern gewissermaßen auch inhaltsverschoben an. Zugleich möchte ich betonen, dass bestimmte Maschinen in gewissen Aspekten durchaus bestimmten Menschen ebenbürtig sind. Sie können beispielsweise konkrete Regeln ebenso strikt befolgen wie religiöse Fundamentalisten. Maschinelle Moral kann also zumindest einen Teil der menschlichen ausmachen.

Moralische und unmoralische Maschinen

Die Maschinenethik hat in ihrer jungen Geschichte vor allem versucht, moralische Maschinen zu konzipieren oder zu implementieren. Mein Augenmerk gilt selbstständig fahrenden Autos, Pflege-, Therapie- und Sexrobotern, Fotodrohnen sowie Chatbots.

In letzterem Bereich sind Prototypen entstanden, zunächst der GOODBOT, der moralisch adäquat agiert und reagiert und mehrere Eskalationsstufen kennt, dann der LÜGENBOT aka LIEBOT, der systematisch Lügen ersinnt. Der GOODBOT, könnte man sagen, ist moralisch oder moralisch gut, der LIEBOT unmoralisch oder moralisch schlecht. Damit soll nicht ausgedrückt werden, dass Lügen generell schlecht ist, und der GOODBOT, der gemäß einer seiner sieben Metaregeln möglichst nicht lügen sollte, war durchaus zu Notlügen fähig. Man darf aber anerkennen, dass systematisches Lügen bei Menschen, die sich frei bewegen und frei denken können, schlecht ist, dass es Vertrauen zerstört, in Beziehungen, Freundschaften, Familien, Gruppen und Gesellschaften, und dass systematisches Lügen bei Maschinen ebenso zersetzend sein kann, sei es auf Websites oder bei Servicerobotern. Ich habe also in meiner Arbeit mit moralischen Maschinen angefangen und bin dann zu den unmoralischen vorgedrungen.

Auch der Roboter des amerikanischen Künstlers und Ingenieurs Alexander Reben, eine nadelbewehrte Maschine, die selbst entscheidet, ob sie einem in den Finger sticht und einen so verletzt, dass es richtig weh tut, kann als unmoralisch bezeichnet werden, insofern er absichtlich und systematisch gegen das Wohl des Menschen verstößt, ohne dass der Zweck die Mittel heiligen würde.

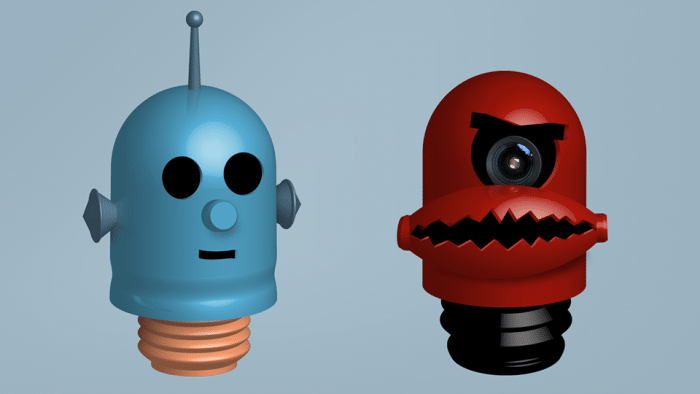

Beide Prototypen, der peinigende Hardware- und der schwindelnde Softwareroboter, sind in ihrer Radikalität gute Beispiele für unmoralische Maschinen, die man für besonders verwerflich hält. Gerade deshalb sind sie interessant für die Maschinenethik, nicht zuletzt, weil man über solche Grenzgänge mit Blick auf moralische Maschinen profitieren kann. Übrigens haben beide bei aller Bösartigkeit eine gewisse Niedlichkeit, der Roboter des Schmerzes durch seinen provisorischen Charakter, der Lügenbot durch seinen animierten Avatar, der rote Bäckchen und eine lange Nase bekommen kann.

Die von mir miterfundene Münchhausen-Maschine – so mein Oberbegriff für Newsportale, Wetterberichte, automatisierte Flirtlines, virtuelle Assistenten, Social Bots und Chatbots, die gezielt die Unwahrheit sagen – ist von besonderer Art. Sie kann nicht nur lügen, sie kann besonders gut lügen. Ich habe sie in mehreren Artikeln, die seit 2013 erschienen sind, ausgedacht und -geformt. Aber erst Kevin Schwegler, den ich im Rahmen seiner Abschlussarbeit an der Hochschule für das Projekt gewonnen habe, hat ihr Leben eingehaucht, künstliches Leben. Er implementierte spezielle maschinelle Strategien des Lügens.

So benutzt der Lügenbot etwa eine Ontologie, eine formale, hierarchische Darstellung von Begrifflichkeiten, und wandert in ihr nach oben und wieder nach unten. Aus "Der Hase hat lange Ohren" wird "Der Igel hat lange Ohren" – eine glatte Lüge. Auch Suchmaschinen und ihre Dienste werden angezapft. In einem Test hat der Liebot auf die Frage, wer der Präsident der USA sei, mit "Donald Trump" geantwortet. Im Moment ist das zum Glück nicht richtig. Im Hintergrund lief ein mehrstufiges Pingpong-Spiel zwischen dem Chatbot und Yahoo. Weiß der Lügenbot gar nicht mehr weiter, wendet er sich an seinen Kollegen, den Cleverbot, und klaut sich eine Antwort von ihm. Der Lügner wird zum Dieb, könnte man sagen.

Es stellt sich die Frage nach dem Zweck moralischer und unmoralischer Maschinen. Bei moralischen Maschinen darf man annehmen, dass sie Missstände beseitigen und Zustände verbessern sollen. Nun ist Wissenschaft nicht immer auf die Gesellschaft oder die Kultur gerichtet, sondern darf sich selbst bestätigen und sich scheinbar sinnfrei betätigen. Moralische Maschinen darf man meines Erachtens auch einfach deshalb bauen, weil man mit ihnen Philosophie und speziell Ethik auf eine andere Art als in den 2500 Jahren zuvor und im wörtlichen Sinne praktizieren kann, und einfach deshalb, weil es faszinierend ist.

Freilich ist das Bauen einer Atombombe nicht weniger faszinierend, und doch sollte man es nicht tun (zumindest sollte man sie unter Verschluss halten). Während man bei moralischen Maschinen zunächst wenige Einwände finden dürfte, liegen bei unmoralischen Maschinen solche auf der Hand. Man kann bei ihnen eben argumentieren wie bei Atombomben: Wissenschaft soll das nicht auf die Welt bringen, was diese zerstört.

Allerdings kann man auf dieser Ebene ebenso gute Gründe für unmoralische Maschinen sammeln. Diese helfen dabei, die Möglichkeiten von Systemen zu verstehen, böse Maschinen zu erkennen und auszuschalten. Wenn man nicht über unmoralische Maschinen forscht und andere diese bauen, ist man letzten Endes hilflos. Überdies helfen die Erkenntnisse, moralische Maschinen zu konstruieren. Durch das LIEBOT-Projekt haben wir besser verstanden, wie man Wissensbasen schützt und Verlässlichkeit beim Treffen von Aussagen herstellt. Es sind Entwickler an uns herangetreten, die sich für die Funktionsweisen interessieren – und dafür, mit Hilfe unseres Chatbots ihre KI-Systeme zu trainieren, damit diese Fakten und Fakes unterscheiden können. Man darf natürlich nicht zuletzt den Standpunkt einnehmen, dass Sein und Sollen in der Wissenschaft verschiedene Dinge sind, moralische Einwände und rechtliche Vorgaben hin oder her. In einer so verstandenen Wissenschaft sollten böse Maschinen gebaut werden können, weil es möglich und der Erkenntnis zuträglich ist.

Die Zukunft der Maschinenethik

Ein grundsätzlicher Einwand gegen die Maschinenethik könnte von anderer Seite kommen. Man könnte beanstanden, dass überhaupt Moral auf Maschinen transferiert oder diesen beigebracht wird, eine solche herauszubilden. Menschen sollen, so der Gedankengang, Verantwortung tragen, und nur sie können sie tragen. Wenn man Moral auf Maschinen verschiebt, entzieht man sich gemäß dieser Position der Primär- und Sekundärverantwortung.

Zwar kann man den Programmierer, den Robotiker, den Manager etc. zur Rede (und vielleicht auch, was die Tertiärverantwortung ins Spiel bringt, vor Gericht) stellen, aber wie erörtert, führen die Maschinen ein gewisses Eigenleben, und es ist schwer vorauszusagen, wie sich ihre moralischen Entscheidungen im konkreten Fall auswirken. Wenn es selbstständig lernende Maschinen sind, ist es nicht leicht, ihre Entscheidungen vorauszusagen, was seit Jahren von KI-Experten und Robotikern thematisiert wird.

Ich persönlich schätze es, wenn Maschinen für mich, z.B. in meinem Haushalt oder in meinem Schrebergarten, moralische Entscheidungen treffen, die ich auch treffen würde. Sie sind in dieser Konstellation meine Stellvertreter, und mein moralisch gutes Handeln wird durch maschinelle Hilfe einfach vermehrt (bzw. in meiner Abwesenheit ermöglicht). Genau solchen Maschinen widme ich mich in meiner Arbeit, mit Fokus auf die Vermeidung von Tierleid, Bentham und Schopenhauer zitierend, und ich konzipiere tierfreundliche Saugroboter und Fahrerassistenzsysteme (Bendel 2016).

Allerdings wird es in der Tat schwierig, wenn wir diese geschützten Räume verlassen und in offene Welten hinausgehen bzw. nicht auf wenige Aufgaben und Situationen einschränken. Ich habe schon betont, dass die moralischen Entscheidungen unpassend sein können, dass sie zeitlich und räumlich versetzt und womöglich inhaltlich unangemessen sind. Dazu kommt das Problem, für wen man Repräsentant in offenen Welten ist. Für den Programmierer, den Robotiker, den Manager, oder den Besitzer, den Betreiber?

In einer Diskussion mit Studierenden haben diese behauptet, sie wären ganz froh, wenn ihnen im Straßenverkehr existenzielle Entscheidungen, etwa über Leben und Tod von Menschen, abgenommen würden. Das ist verständlich, aber genau davor würde ich warnen. Solche Entscheidungen sind unser Schicksal. Nehmen wir es in die Hand und überlassen wir es nicht den Maschinen.

Literatur

- (Bechtel 1985): Bechtel, William. Attributing responsibility to Computer Systems. In: Metaphilosophy, Oktober 1985 (Vol. 16, 4). S. 296 – 306.

- (Bendel 2016): Bendel, Oliver. Annotated Decision Trees for Simple Moral Machines. In: The 2016 AAAI Spring Symposium Series. AAAI Press, Palo Alto 2016. S. 195 – 201.

- (Bendel 2014): Bendel, Oliver. Wirtschaftliche und technische Implikationen der Maschinenethik. In: Die Betriebswirtschaft, 4/2014. S. 237 – 248.

- (Bendel 2012): Bendel, Oliver. Maschinenethik. [1] Beitrag für das Gabler Wirtschaftslexikon. Springer Gabler, Wiesbaden 2012.

- (Snapper 1985): Snapper, John W. Responsibility for Computer-Based Errors. In: Metaphilosophy, Oktober 1985 (Vol. 16, 4). S. 289 – 295.

URL dieses Artikels:

https://www.heise.de/-3344452

Links in diesem Artikel:

[1] http://wirtschaftslexikon.gabler.de/Definition/maschinenethik.html

Copyright © 2017 Heise Medien