Quo vadis, Teilchenphysik?

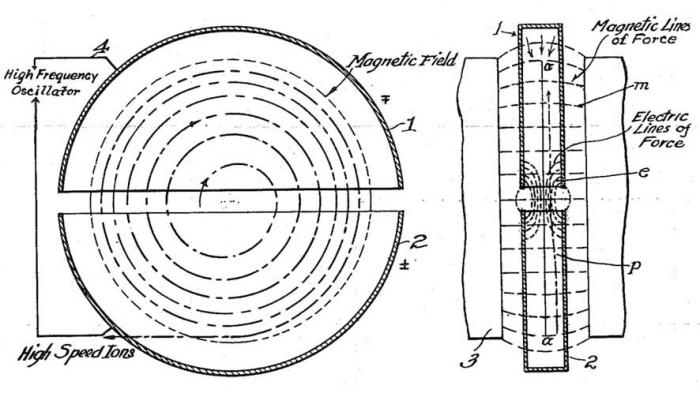

Diagramm der Funktionsweise des Lawrence-Zyklotron. Bild: U.S. Patent 1,948,384 - Ernest O. Lawrence - Method and apparatus for the acceleration of ions

Eine wissenschaftstheoretische Betrachtung zu CERN und Higgs

Der amerikanische Physiker Ernest O. Lawrence hatte 1929 eine großartige Idee: Er baute einen Beschleuniger, in dem geladene Teilchen durch ein Magnetfeld auf Kreisbahnen gehalten wurden, so dass sie noch höhere Geschwindigkeiten erreichten, ehe sie durch eine energiereiche Kollision ihre Struktur offenbaren sollten.

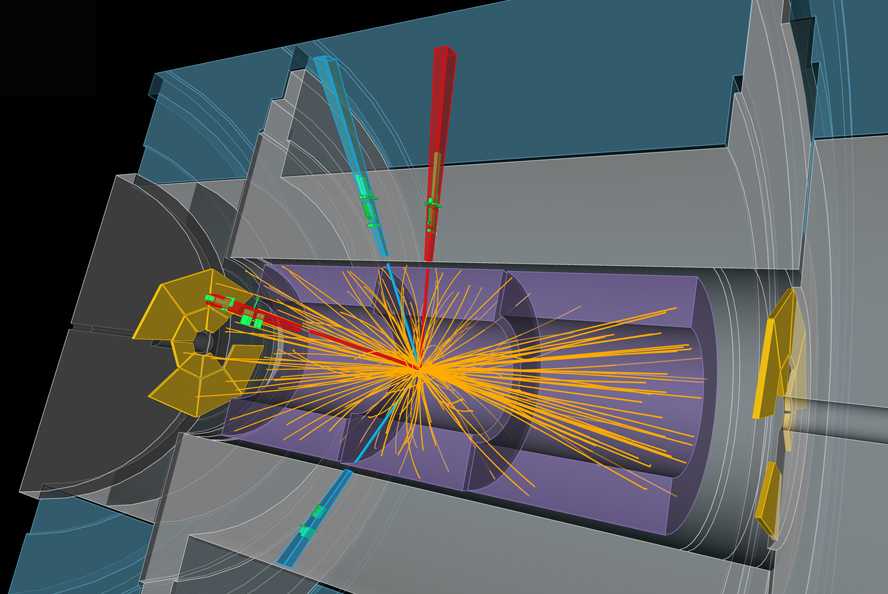

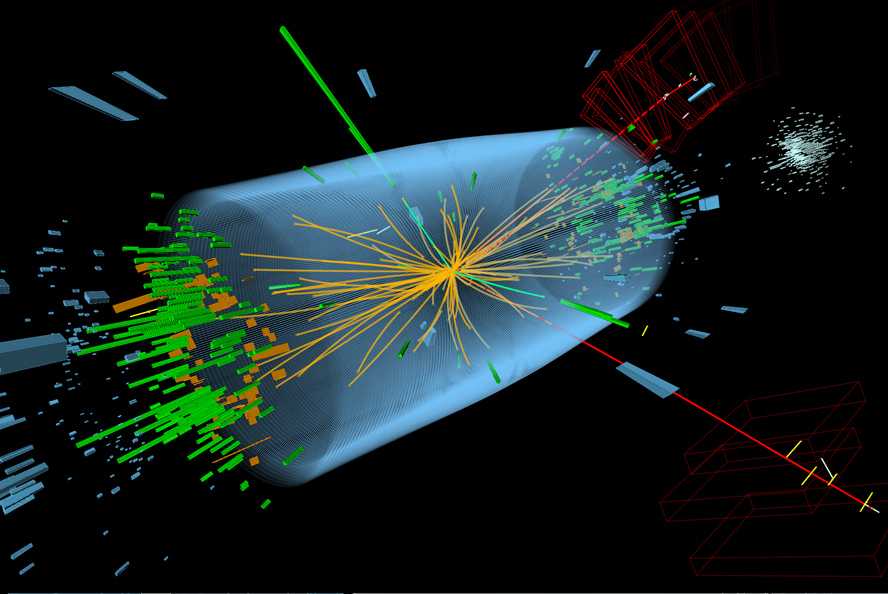

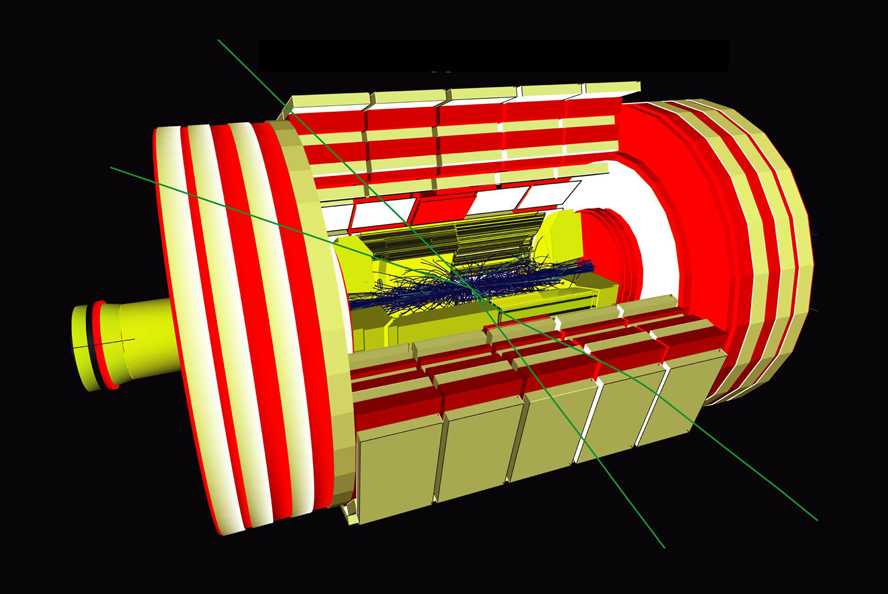

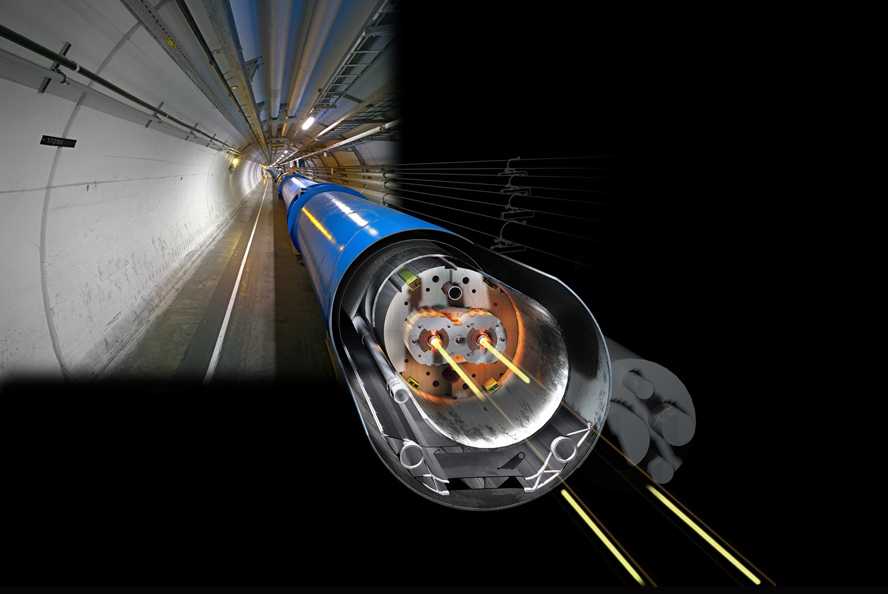

Die handtellergroße Konstruktion von Lawrence, genannt Zyklotron, war die erste Entdeckungsmaschine der Teilchenphysik. Das Prinzip des Zyklotrons wurde nun in bisher unerreichter Größe und Perfektion realisiert, im 27 Kilometer langen Tunnel des Large Hadron Collider [1] am CERN, wo Protonen mit praktisch Lichtgeschwindigkeit aufeinanderprallen.

Die Früchte eines Jahrhunderts physikalischer und technischer Evolution stecken in diesem gigantischen Projekt, angefangen von der phänomenalen Supraleitung knapp über dem absoluten Temperaturnullpunkt, die so starke Magnetfelder überhaupt erst ermöglicht, über Hightech-Detektoren, die die Spuren der Kollisionen aufzeichnen, bis hin zur sumbillimetergenauen Computersteuerung der Protonenstrahlen. Allein die Anlage als solche erzeugt zu Recht Faszination für das, was der Mensch in seinem Wissensdrang erschaffen kann - es ist unmöglich, vom LHC nicht begeistert zu sein. Dass der Beschleuniger trotz der enormen Herausforderungen auch noch so gut funktioniert, ist eine Leistung aller Beteiligten, die höchsten Respekt verdient.

Technische Evolution und physikalische Rätsel

Dennoch - wissenschaftlicher und technischer Fortschritt beeinflussen sich zwar, gehen aber selten im Gleichschritt. Und gerade beim Large Hadron Collider, auf dessen Ergebnisse man seit Jahrzehnten gespannt ist, fällt es schwer, von der Tagesaktualität Abstand zu halten und die langen Zeiträume zu betrachten, in denen die wissenschaftliche Erkenntnis fortschreitet. Und so ist etwas Vorsicht geboten, wenn kurz nach dem technischen Erfolg auch die im LHC gewonnenen Erkenntnisse schon als historisch bezeichnet werden. Neben der Freude über das Gelingen des Projektes muss man sich hier an den Zweck erinnern - die tiefen Fragen der Natur zu entschlüsseln. Dazu eine kleine Rückblende.

Die 1865 von James Clark Maxwell formulierte Elektrodynamik wurde 1888 durch Heinrich Hertz sensationell bestätigt, der nachwies, dass sich elektromagnetische Wellen mit Lichtgeschwindigkeit ausbreiten - kaum eine Entdeckung beeinflusste unsere Zivilisation so nachhaltig wie diese. Elektromagnetische Wellen entstehen, wenn in einer Antenne Ladungen beschleunigt werden. Dennoch hat die Physik bis heute keine allgemeingültige Formel zur Hand, die die Abstrahlung einer sehr stark und beliebig beschleunigten Ladung beschreibt. Dies liegt daran, dass die Theorie den starken elektrischen Feldern eine Energiedichte zuschreibt, die nach Einsteins spezieller Relativitätstheorie jeder Ladung eine unendlichen Masse verleihen würde. Alle Physiker sind sich darin einig, dass die klassische Elektrodynamik in sich widersprüchlich ist - ein Problem, das auch im Jahr 2013 noch einer Lösung harrt.

Solche ungelösten Fragen der Physik sind zahlreich, und exemplarisch seien hier zwei herausgegriffen: Die Zahl 137,035999, der Kehrwert der Feinstrukturkonstanten, ist eine bemerkenswerte Mitteilung der Natur, die durch die Zusammenarbeit von raffinierten Experimenten gemessen wird. Theoretisch berechnen kann man sie jedoch bis heute nicht. Richard Feynman bezeichnete dies als "eines der verdammt großen Rätsel der Physik".

An dieser Stelle ist es wichtig zu betonen, dass echt wissenschaftliche Theorien stets quantifizierbar sind, also konkrete Zahlen vorhersagen, die dann im Experiment überprüft werden können. Für Feynman bestimmte die prozentuale Übereinstimmung die Qualität einer Theorie, aber schon Isaac Newton forderte von der Physik quantitative Resultate: "Gott hat alles mit Maß, Zahl und Gewicht erschaffen."

Ebenso rätselhaft wie die Feinstrukturkonstante ist die Zahl 1836,15.., das Massenverhältnis von Proton und Elektron - um 1930 übrigens die einzigen bekannten Teilchen der Physik. Paul Dirac grübelte jahrelang, wie man diese Zahlen berechnen könnte - und scheiterte, ebenso wie Einstein, Schrödinger und Heisenberg.

Einfachheit in den Naturgesetzen - ein Axiom aus der Mode

Warum aber haben die größten Physiker der Neuzeit so viel Kraft auf diese Fragen verwendet? Sie waren überzeugt, dass fundamentale Naturgesetze einfach sein müssen. Jede unerklärte Zahl war ihnen dabei zuwider, jede Willkürlichkeit schien ihnen ein Geheimnis, das ihnen die Natur noch vorenthielt.

Viele Debatten über die Grundlagen der Physik entzünden sich gerade an diesem Punkt, ob die Physik denn einfach sein muss. Natürlich muss sie nicht. Aber es liegt eine Gefahr darin, unser mögliches Nichtverstehen damit zu entschuldigen, die Natur sei nicht verständlich. Und man muss sich bewusst sein, dass Einstein, Schrödinger, Heisenberg, Pauli und Dirac, aber auch Ernst Mach, Max Planck und Nils Bohr ihre Arbeit in einer philosophischen Tradition sahen, die die Einfachheit der Naturgesetze als Selbstverständlichkeit voraussetzte. Denkbar, dass sie alle einem falschen Ideal nachhingen - aber wenn man die aktuellen Erkenntnisse der Physik historisch einordnen will, kann man darüber nicht hinwegsehen.

Big Science macht Weltgeschichte, Philosophie ad acta

Während um 1930 Fragen wie zur Feinstrukturkonstante und zu den Massen der Elementarteilchen (und einige andere Fragen) noch auf dem Tisch lagen, lieferte die Teilchenphysik bereits interessante Ergebnisse, nicht zuletzt durch das von Lawrence entwickelte Zyklotron. Während sich die Theoretiker über die Interpretation der gerade entwickelten Quantenmechanik stritten, konzentrierte sich eine pragmatische Generation von Physikern auf die Fortführung der experimentellen Forschung. Dennoch muss man hier festhalten, dass dies keine geradlinige Weiterentwicklung des Wissens war, sondern eher eine Verzweigung, um nicht zu sagen Übersprungshandlung. Denn zu den ungelösten Fragen trugen die neuen Teilchen zunächst nichts bei.

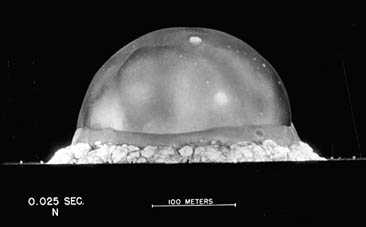

Physikgeschichte ist auch Teil der Geschichte. Ende der 1930er Jahre begannen die Nationalsozialisten die wissenschaftliche Kultur in Europa samt ihren philosophischen Denktraditionen zu zerstörten, und noch während des Untergangs des Dritten Reiches gelangte die Physik ausgerechnet durch die Entwicklung der Atombombe ins Rampenlicht. Die nun mächtige Forschergeneration des Manhattan Project begründete ein Paradigma einer technikgeleiteten Physik. Sie schob die Grenzen des experimentell Machbaren immer weiter voran, beschrieb jedoch die Ergebnisse in Modellen, welche jene grundlegenden Fragen ausklammerten.

Diese Art von Physik, Big Science, dominierte ab der zweiten Hälfte des 20 Jahrhunderts, und obwohl sie in mancher Hinsicht eine Erfolgsgeschichte war, stellte sie doch einen Bruch mit den naturphilosophischen Prinzipien dar - Einstein, Schrödinger und Dirac starben als Außenseiter.

Der Teilchenzoo und die Parallele zum Mittelalter

Die meist auf nach dem Prinzip des Zyklotrons konstruierten Beschleuniger produzierten in der Nachkriegszeit so viele neue Teilchen, dass es sogar Enrico Fermi beunruhigte, der 1950 sagte: "Die Wahrscheinlichkeit, dass es sich um wirklich elementare Teilchen handelt, nimmt mit Ihrer Anzahl stetig ab." In einer Art Gegenbewegung wurden die Hunderten von Elementarteilchen ab den 1960erJahren in einem Schema geordnet, dem sogenannten Standardmodell der Teilchenphysik, das bis heute als Grundlage des Verständnisses gilt.

Trotz der relativen Vereinfachung konnte das Modell jedoch die vorherige Teilchenproduktion nicht wettmachen, es blieb, absolut gesehen, doch einigermaßen kompliziert: Das ehemalige Proton wird heute als aus Quarks zusammengesetzt angesehen, welche in sechs "Geschmacksrichtungen" auftreten: up, down, charme, strange, bottom und top. Zudem kommt jede dieser Sorten sowohl in drei "Farben" vor, als auch als Antiteilchen, so dass allein 36 sogenannte schweren Teilchen (Hadronen) existieren.

Dazu gesellen sich zwei weitere Partnerteilchen des Elektrons (Leptonen), mit dazugehörigen Neutrinos, sowie eine Palette sogenannter Bosonen, zu denen auch das 2012 aufgespürte Higgs-Teilchen gehört. Insgesamt also über 50 elementarster Teilchen, von denen jedes einen oder mehrere Eigenschaften in sich trägt, die Einstein willkürliche Zahlen genannt hätte. Man fühlt sich beim heutigen Standardmodell an einen Ausspruch von König Alfonso dem X. von Kastilien erinnert: "Hätte mich der Herrgott bei der Schöpfung um Rat gefragt, hätte ich etwas einfacheres empfohlen."

Alfonso tat diesen Ausspruch, als er in der Bibliothek von Toledo von dem komplizierten geozentrischen Planetenmodells erfuhr. In der Tat drängt sich diese Parallele zur mittelalterlichen Astronomie auf: Als die Beobachtungen damals zeigten, dass die Planetenbahnen keine perfekten Kreise um die Erde waren, postulierte man sogenannte Epizyklen, auf einem Kreis montierte kleinere Kreisbahnen, die die am Himmel beobachtete Bewegung etwa von Mars befriedigend wiedergaben. Und als genauere Beobachtungen erneut eine Abweichung zeigten, behalf man sich mit der Erklärung, der Mittelpunkt des aufgesetzten Kreises sei um einen kleinen Betrag verschoben.

Aus heutiger Perspektive kommt uns dies reichlich bizarr vor, jedoch war das mittelalterliche Planetenmodell durchaus wissenschaftlich zu nennen und stimmte ziemlich gut mit den Beobachtungen überein. Aber die Präzision wurde erkauft mit freien Parametern, eben jenen unerklärten Zahlen, die die Theorie lediglich an die Messungen anpasst. Und je mehr solcher Parameter es gibt, desto besser funktioniert dies. Im heutigen Standardmodell ist ihre Anzahl beunruhigend hoch - jedenfalls über fünfzig. Was man auch immer als experimentelle Rechtfertigung anführen mag, man kann es wohl kaum mehr Physik in der Tradition von Newton nennen, dessen Credo war: "Wahrheit kann, wenn überhaupt nur in der Einfachheit gefunden werden, nicht in der Vielgestaltigkeit und Vermischung der Dinge."

Wissenschaft wird von Menschen gemacht

Aber ist es nicht naiv, zu glauben, die moderne Wissenschaft könne einen Irrtum aus dem Mittelalter wiederholen? Leider ist die Wissenschaftsgeschichte voll solcher Beispiele: es sei hier nur kurz erwähnt das Übersehen der Kernspaltung bis 1938, der Kontinentaldrift bis 1960 oder die hundert Jahre zu spät entdeckte Rolle der Oxidationen in der Chemie.

Der Wissenschaftsphilosoph Thomas Kuhn hat dies treffend in seinem Werk "The structure of scientific revolutions" beschrieben, dessen Kernaussage die Nicht-Stetigkeit des wissenschaftlichen Fortschritts ist. Üblicherweise wird an akzeptierten Modellen lange festgehalten, und widersprechende Beobachtungen, sogenannte Anomalien, integriert man in der Regel durch zusätzliche Annahmen in das Modell, das auf diese Weise unweigerlich komplizierter wird. So gesehen, könnte die Geschichte der Teilchenphysik dafür ein Paradebeispiel sein. Denn auch in der modernen Physik seit 1930 bestand der oft sehr indirekte Nachweis eines Teilchens meist darin, dass die Beobachtungen mit dem bis dahin einfacheren Modell nicht zu erklären waren.

Kuhns Thesen scheinen im Übrigen eine natürliche Konsequenz menschlichen Verhaltens. Es ist vergleichsweise leicht, Wissenschaftler von einem neuen Konzept zu überzeugen, auch wenn es das bestehende Modell kompliziert. Denn dieses wird ja durch die beseitigten Widersprüche stabilisiert, und nicht zuletzt auch durch die neu hinzugekommenen Forscher, die im neuen Konzept ein Arbeitsgebiet finden. Umgekehrt wird jeder Zweifel an der Richtigkeit des bestehenden Modells die erbitterte Feindschaft all jener hervorrufen, die ihre Arbeitsgrundlage bedroht sehen. Komplizierung scheint eine denknotwendige Folge menschlichen Handelns, das Konsens gegenüber der Konfrontation bevorzugt.

In seinem Buch Nobel Dreams (eine äußerst lesenswerter Insiderbericht über die Hochenergiephysik am CERN) formuliert Gary Taubes trocken: "Niemand hat je einen Nobelpreis für den Nachweis gewonnen, dass etwas nicht existiert." Das ausgezeichnete Buch Constructing Quarks des Teilchenphysikers Andrew Pickering räumt darüber hinaus mit dem Vorurteil auf, das Experiment sei immer eine eindeutige Aussage der Natur. Pickering beschreibt an detaillierten Beispielen, wie ein Anpassen der experimentellen Methoden an eine theoretische Erwartungshaltung konkret beeinflussen kann, was als experimentelles Faktum anerkannt wird.

Alle neu erschaffenen Konzepte der vergangenen Jahrzehnte waren für sich plausibel. Doch jeder unbegründete Zusatz, auch wenn er sich als Entdeckung präsentiert, ist eine subtile erkenntnistheoretische Niederlage. Echte wissenschaftliche Revolutionen vermehrten aber nie die Anzahl der unerklärten Parameter in der Physik, sondern verringerten sie - so wie die Maxwellsche Elektrodynamik, die die Lichtgeschwindigkeit über die elektrischen Konstanten berechnete.

Auf der Suche nach harten Fakten

Erstaunlich oft hört man in Diskussionen, das Standardmodell sei experimentell präzise getestet. Durch die vielen freien Parameter ist dies eigentlich kein Qualitätsmerkmal, aber die Aussage hält auch einer näheren Überprüfung nicht stand. Bei Einsteins Allgemeiner Relativitätstheorie stimmen Theorie und Beobachtung, etwa bei der Ablenkung von Quasarlicht, im Promillebereich überein, und die Quantenelektrodynamik bestätigt die Präzisionsmessungen der Atomphysik sogar mit noch mehr Nachkommastellen. Vergleichbare Präzision wird vom Standardmodell der Teilchenphysik nicht annähernd erreicht.

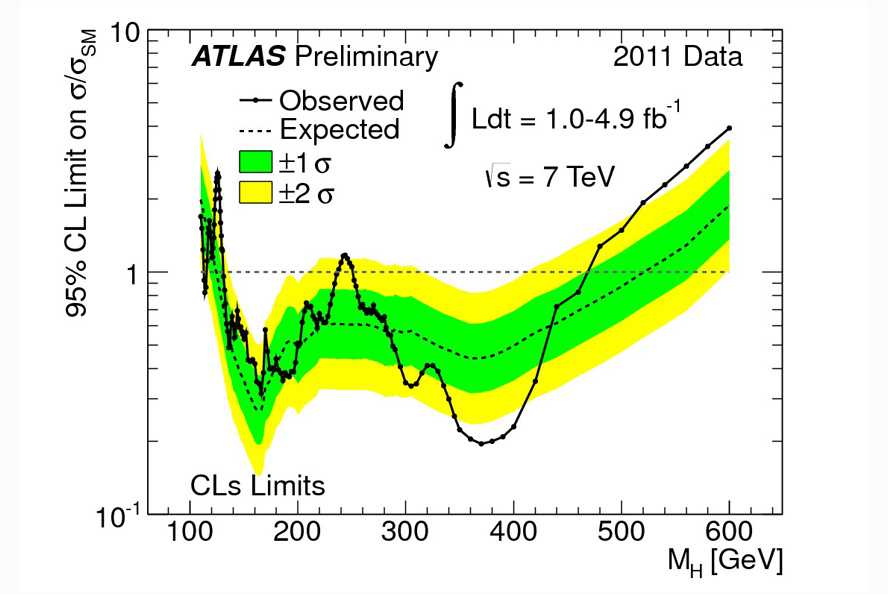

Meist werden qualitative Argumente angeführt, wie die Existenz von Neutralströmen in den 1970er Jahren, die Existenz von W- und Z-Teilchen 1984 - oder eben die Entdeckung des Higgs-Bosons [3], womit wir wieder in der Gegenwart sind. Angeblich vermittelt das Higgs-Boson die Einsicht, die Massen der Teilchen entstehen, aber auf Diracs Frage, warum das Proton 1836 mal so schwer wie das Elektron ist, hätte die moderne Physik nur die Antwort: Weil die Bestandteile des Protons 1836 mal so stark vom Higgs-Feld beeinflusst sind wie das Elektron. Erkenntnistheoretisch liegt darin noch nicht viel Fortschritt.

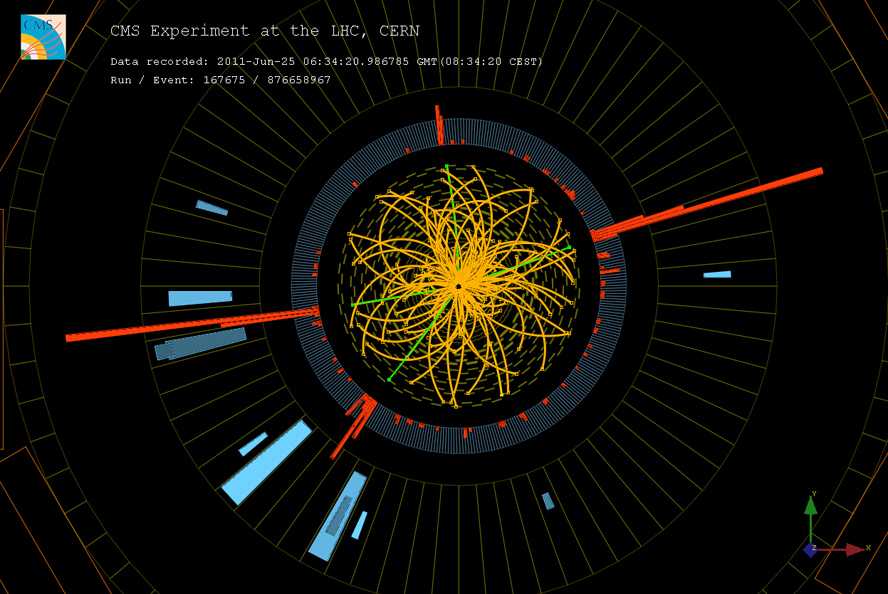

Bis hierher mag dies als sehr allgemeine Betrachtung erscheinen, die sich vielleicht im Lichte der experimentellen Fakten am CERN doch als zu skeptisch erweist. Es gibt aber ein paar ganz konkrete Gründe, warum sich jeder ausgebildete Physiker über die Datenauswertung am CERN eigentlich wundern müsste. Die wichtigste Evidenz für das Higgsteilchen ist, dass zwei zusätzliche Photonen bei der Protonenkollision entstehen. Dies ist erstaunlich, weil sich praktisch alle Teilchenpaare sich in Photonen umwandeln, und man fragt sich daher, wie aus einem so uncharakteristischen Ereignis die Existenz eines Teilchen mit so speziellen Eigenschaften gefolgert werden kann.

Vor allem bedeutet aber "zusätzlich" in diesem Fall, dass bei ca. einer Billion (!) gleichartigen Photonenpaaren im Mittel eines davon zu viel erzeugt wird. Die Datenauswertung geht also davon aus, alle anderen Umwandlungsprozesse genau zu verstehen und herausrechnen zu können. Der Versicherung, all dies werde höchst sorgfältig gemacht, möchte man gerne glauben, wäre da nicht das seit 1888 ungelöste Rätsel der Physik, dass man die Lichtabstrahlung von sehr stark beschleunigten Ladungen gar nicht präzise berechnen kann - es gibt keine Formel dafür, weil die Elektrodynamik starker Felder widersprüchlich ist.

Beim Aufprall von geladenen Teilchen, und genau dies passiert bei den Kollisionen, entstehen die größten Beschleunigungen (Abbremsungen, also mit negativem Vorzeichen), die die Physik überhaupt kennt. Wie kann man in einer experimentell noch nie dagewesenen Situation die Lichtabstrahlung von Photonen auf ein Billionstel genau modellieren, wenn die Physik anerkanntermaßen dazu keine präzise Theorie zur Verfügung hat?

Unglaublich kurzlebig

Eine weitere gravierende Irritation stellen die Lebensdauern der Teilchen des Standardmodells dar, etwa die des Top-Quarks in der Größenordnung von 10-25 s. Selbst bei Bewegung nahe an der Lichtgeschwindigkeit, und selbst wenn es nach Einsteins spezieller Relativitätstheorie eine etwas längere Lebensdauer spürt, kann dieses Teilchen nur etwa den Durchmesser eines Protons zurücklegen, zerfällt also lange bevor es den Kollisionspunkt mit seinem Gewirr von 600 Millionen pro Sekunde aufeinanderprallenden Teilchen verlassen kann.

Ein so kurzlebiges Teilchen kann nie direkt einen Detektor erreichen, und der Nachweis basiert einzig auf indirekten Rückschlüssen über Zerfallsprodukte, deren Verhalten man genau zu kennen glaubt (Dabei sind sich jüngst Wissenschaftler zum Beispiel über die Größe des Protons uneinig). Und es ist auch nicht verwunderlich, wenn verschiedene Detektoren wie ATLAS und CMS das Top-Quark "sehen" - es kommt ja weder in dem einen noch in dem anderen an, sondern wird aus nachfolgenden, wohl nicht sehr verschiedenen Computersimulationen postuliert.

Bei der Analyse der Higgs-Daten werden unter anderem Top-Quarks vorausgesetzt. Das Higgs-Boson selbst hingegen gilt in der Theorie mit etwa 10-22 s als relativ langlebig. Nachgewiesen ist diese lange Lebensdauer aber keineswegs - dazu müsste die Breite des Signals in der Energiedarstellung (eine Konsequenz der Heisenbergschen Unschärferelation) fast tausendmal schmäler werden. Dies und andere Merkmale machen es im Moment völlig unabsehbar, ob das im Juli 2012 gefundene Signal jemals mit den Eigenschaften des Higgs-Bosons identifiziert werden kann.

Das zutreffende Eingeständnis, man sei sich noch nicht sicher, wird in der öffentlichen Diskussion gerne mit der Wahrscheinlichkeit von 99,999% vermischt, die über die statistische Signifikanz etwas aussagt, ob man etwas gefunden hat - aber nichts darüber, was. So warnt Wikipedia sogar explizit vor dem Eintrag zu behaupten, das Higgs-Boson sei entdeckt.

Ist alles willkommen?

Eine bizarre Wendung erfährt die Diskussion bei jüngsten Ergebnissen, die den Vorhersagen widersprechen - dies sei, so hört man, ein Hinweis auf ein "Nicht-Standardmodell-Higgs-Teilchen", was auch immer das bedeuten soll. Es fällt nicht nur schwer, in diesem "Nicht-Standardmodell-Higgs-Teilchen" einen Triumph des Standardmodells zu erkennen, sondern es drängt sich die Frage auf, ob die Möglichkeiten, dieses Standardmodell in Zukunft zu modifizieren, nicht unbeschränkt sind und die Anzahl der zur Beschreibung nötigen Parameter nach oben offen.

Einstein, Dirac oder Schrödinger, daran kann kein Zweifel bestehen, hätten so ein Modell für absurd gehalten. Dies ist noch kein zwingendes Argument, aber vieles deutet darauf hin, dass wir uns in einer Krise des wissenschaftlichen Weltbildes befinden, wie sie Thomas Kuhn beschrieben hat. Die meisten Physiker spüren sogar beim Standardmodell ein Unbehagen, geben sich aber der Hoffnung hin, es könne repariert werden. Leider widerspricht hier Kuhn: Solche Modelle waren in der Wissenschaftsgeschichte nie nur ein bisschen falsch, sonder wenn, dann komplett.

An diese Möglichkeit auch nur zu denken, ist grausam. Die Vorstellung, Zehntausende von Physikern beschäftigten sich seit Jahrzehnten mit der Untersuchung eines Modells, das ähnlich falsch ist wie das geozentrische Planetenmodell, ist so alarmierend, dass eine emotionslose Diskussion darüber oft gar nicht mehr stattfindet. Daher ist auch das stärkste intuitive Argument, auch wenn sich manche dessen sich gar nicht bewusst sind, dass sich so viele Forscher gar nicht irren können. Belegt von der Wissenschaftsgeschichte ist dieses Argument nicht. Und gerade in der Teilchenphysik steht die Anzahl der beteiligten Wissenschaftler in scharfem Kontrast zu der Anzahl derer, die die eigentlichen Beobachtungen aus eigener Kenntnis wiedergeben können.

Es ist beunruhigend, dass aufgrund der Komplexität der Experimente das Wissen in der Physik nur mehr auf der Ebene des Endergebnisses weitergegeben wird - basierend auf gegenseitigem Vertrauen. Damit soll keineswegs Verschwörungstheorien das Wort geredet werden, weil sich die beteiligten Wissenschaftler nach bestem Wissen und Gewissen um die Auswertung bemühen - aber dass die Analyse des Experiments von keinem einzelnen mehr überblickt werden kann, ist ein Faktum.

Mit alledem ist kein Vorwurf verbunden. Keinen Forscher trifft Schuld, wenn er in seinem schwierigen Bemühen, Naturgesetze zu verstehen, zu falschen Schlüssen gerät. Aber Wissenschaft kennt, wie Romain Rolland einmal sagte, auch kein Mitleid. Philosophische, historische und methodische Gründe legen nahe, dass sich die heutige Teilchenphysik in einer Sackgasse befindet. Und niemandem ist gedient, wenn man vor dieser Möglichkeit auf Dauer die Augen verschließt.

Konstruktives - das gläserne Experiment

Es wäre unfair, diese Betrachtung ohne konstruktive Vorschläge zu beenden. Das Problem an den Ergebnissen der Hochenergiephysik der letzten Jahrzehnte ist, dass sie in der Sprache formuliert sind, die die Interpretation im Rahmen des Standardmodells schon vorwegnimmt. Alternative Ideen müssten hingegen Daten zur Verfügung haben, die schlicht aussagen, welcher Energiebetrag wann und wo im Detektor abgegeben wurde. Und es ist keineswegs so, dass nur Experten der Hochenergiephysik qualifiziert wären, solche Daten zu analysieren. Vielmehr wäre es durchaus vorstellbar, dass ein Student aus Indien oder ein Ingenieur aus Mexiko darin überraschende Zusammenhänge findet, an deren Analyse vorher noch nie jemand gedacht hat.

Dagegen dringt von den Kollaborationen der Teilchenphysik, obwohl man oft von internen Kontroversen hört, nicht viel nach außen, was nicht den Konsensfilter einer gemeinsamen Veröffentlichung überstanden hat. Gegen die völlige Offenlegung von Daten wird auch oft argumentiert, diese seien für den Außenstehenden wertlos, weil Effekte der Instrumente nur der Experte korrigieren könne. Leider ist dies sogar wahr, offenbart aber nur verquere Sicht der Dinge: Wenn die Naturgesetze nicht vom Detektor abhängig sein sollen, wäre es genau die Aufgabe, die Rohdaten soweit aufzubereiten, dass die speziellen Instrumente darin keine Rolle mehr spielen.

Auch hier hat sich die Physik weit von der Methode des vergangenen Jahrhunderte entfernt, die die permanente Überprüfbarkeit und Wiederholbarkeit von Experimenten als Grundlage hatte. Zu oft werden Prinzipien, die den Erfolg der Naturwissenschaft seit 400 Jahren ausmachten, den Sachzwängen in den modernen Großforschungseinrichtungen geopfert. Sollte sich die fundamentale Physik tatsächlich auf einem Irrweg befinden, hat sie mit den derzeitigen Strukturen auch kaum eine Chance, herauszufinden.

Eine Lösung kann nur sein, das gläserne Experiment zum Prinzip wissenschaftlicher Datengewinnung zu machen. Die Rohdaten müssen zugänglich werden, aber auch jeder Zwischenschritt der Datenauswertung, die damit auf unbegrenzte Zeit von einer unbegrenzten Anzahl von Wissenschaftlern überprüft werden könnte. Dies wäre eine methodische Umwälzung, die die Physik langfristig beeinflussen würde. Möglich ist sie im Prinzip - nicht zuletzt dank des am CERN erfundenen Internet.

Alexander Unzicker ist Autor der Bücher "Auf dem Holzweg durchs Universum - warum sich die Physik verlaufen hat" (Hanser, 2012) und "Vom Urknall zum Durchknall - die absurde Jagd nach der Weltformel", dem Wissenschaftsbuch des Jahres 2010 in der Kategorie "Brisant". Es erscheint im Juli 2013 auf Englisch unter dem Titel "Bankrupting Physics" bei Palgrave Macmillan.

URL dieses Artikels:

https://www.heise.de/-3397391

Links in diesem Artikel:

[1] http://lhc.web.cern.ch/lhc/

[2] http://creativecommons.org/licenses/by-sa/3.0/deed.de

[3] http://press-archived.web.cern.ch/press-archived/PressReleases/Releases2012/PR17.12E.html

Copyright © 2013 Heise Medien