Bildmanipulation als Grand Challenge für die Wissenschaft

Thorsten Beck über gefälschte Abbildungen und technische Lösungen zu ihrer Erkennung

Thorsten Beck ist am Humboldt Elsevier Advanced Data & Text Centre (HEADT) tätig und befasst sich mit maschinellen Verfahren der Erkennung manipulierter Darstellungen in wissenschaftlichen Publikationen. Im Interview bilanziert er den Stand der Forschung und Technik und spricht über die Rolle von Verlagen und Journalen sowie den Stellenwert der wissenschaftlichen Ausbildung.

Herr Beck, Sie befassen sich mit maschinellem Erkennen gefälschter Abbildungen in wissenschaftlichen Publikationen. Was führte Sie zu dieser Thematik?

Thorsten Beck: Auf das Thema bin ich durch meine Tätigkeit als wissenschaftlicher Mitarbeiter im Interdisziplinären Labor Bild Wissen Gestaltung der Humboldt-Universität gestoßen.

Dabei war ich zunächst für ein Projekt tätig, bei dem es darum ging, visuelles Wissen in seiner Komplexität zu verstehen. Ich habe dafür andere Wissenschaftler befragt und mir angeschaut, mit welchen Bildern sie arbeiten und welche Informationen sie jeweils mit Bildern vermitteln. Wir haben dann aus diesen Beobachtungen eine Ausstellung produziert und das Gespräch über Bilder und Wissen vertieft.

Bei meinen Recherchen und in vielen Gesprächen im Labor bin ich immer wieder über das Thema Bildmanipulation gestolpert. Mit Herr Prof. Bredekamp war ja auch ein prominenter Kunsthistoriker in der Leitung des Exzellenzclusters und bei vielen Gelegenheiten wurde die Frage gestellt, ob die Präsentation der Bilder dem Zweck angemessen, was eine angemessene Manipulation sei. Ich wurde also quasi automatisch für das Thema sensibilisiert und als mein späterer Doktorvater, Prof. Michael Seadle, mich dazu ermutigte, eine Promotion zu schreiben, musste ich über das Thema nicht lange nachdenken.

Problem für die Glaubwürdigkeit von Wissenschaft

Warum stellen manipulierte Abbildungen in wissenschaftlichen Publikationen eine Gefahr für die Integrität der Wissenschaft dar?

Thorsten Beck: Erst einmal - jedes Bild ist zu einem gewissen Maß das Produkt von Manipulationen. Es gibt kaum ein Bild, das nicht in irgendeiner Form das Ergebnis bewusster Entscheidungen wäre. Viele Entscheidungen trifft aber auch schon die Kamera selbst. Aber Bilder werden auch beschnitten und so nachbearbeitet, dass sie ein gewünschtes Objekt klar und deutlich zeigen. Daran ist erst einmal nichts falsch. Wenn wir über das Problem manipulierter Bilder in wissenschaftlichen Publikationen sprechen, geht es darum, dass entweder durch Unkenntnis oder unsauberes Arbeiten oder aber durch bewusste Täuschungsabsicht Bilddaten verfälscht werden - dass also eine Grenze überschritten wird.

Noch einmal zu Ihrer Frage - wenn unangemessene Manipulationen nicht erkannt werden, dann schleichen sich Fehler in die Wissenschaft ein, die im schlimmsten Fall sehr konkrete Auswirkungen auch auf die Gesundheit von Menschen haben können. Wenn wir von der "Integrität der Wissenschaft" sprechen, meinen wir die Zuverlässigkeit der Erkenntnisse, aber auch die Verlässlichkeit von Daten und eines ganzen Systems. Je häufiger wissenschaftliche Erkenntnisse als Fälschungen entlarvt werden, desto gravierender die Folgen für die Glaubwürdigkeit von Wissenschaft.

Ich muss nicht betonen, wie wichtig heutzutage gerade das Ansehen der Wissenschaft in der Öffentlichkeit ist, besonders mit Blick auf gesellschaftliche Krisen, wie eine Pandemie, den Klimawandel oder die Auswirkungen von Gentechnik. Wenn WissenschaftlerInnen meinen, Sie könnten existierende Standards ignorieren oder Ergebnisse einfach simulieren und fälschen, dann ist das für die Verlässlichkeit von Forschung ein ernstes Problem.

Genauso verhält es sich mit Bildern, die recycelt werden. Das ist öfter der Fall als man annehmen sollte. Bei einem Großteil der bekannten Bildmanipulationen handelt es sich tatsächlich um Duplikate - also um Bilder, die wiederverwendet werden. Auch Bildplagiate sind nicht selten. Anders als bei Texten lassen sie sich allerdings nicht einfach durch eine Software identifizieren — auch das trägt dazu bei, dass die Integrität von Wissenschaft untergraben wird.

Welche Arten von Abbildungen werden denn von Ihnen untersucht?

Thorsten Beck: Wir haben den Fokus in der Vergangenheit vor allem auf bio-medizinische Abbildungen gelegt, einfach, weil Probleme mit Bildern dort relativ häufig sind. Unser Ziel war es zunächst einmal, einen Fundus von Fällen zu sammeln und diese systematisch zu erfassen, um das Problem besser zu verstehen. Dazu haben wir eine spezielle Datenbank aufgebaut (hu-berlin.de/IIDB).

Zu den häufigsten Bildern, die manipuliert werden, gehören dabei die sogenannten Western-Blots. Solche Blot-Sequenzen dienen der Analyse von Proteinreaktionen auf einer Trägermembran. Im Grunde sind das für den Außenstehenden erst einmal sehr abstrakte Darstellungen und es braucht eine ganze Weile, bis man versteht, welche Manipulationen die Interpretation solcher Bilddaten verändern können. Aber wir sind auch nicht monothematisch unterwegs und haben für unsere Ausstellungen auch immer wieder Bilder aus dem Bereich Kunstgeschichte, Astronomie oder aus fotografischen Wettbewerben analysiert und dokumentiert.

Welches war Ihrer Meinung nach der aufsehenerregendste Fall einer entdeckten Bildmanipulation?

Thorsten Beck: Man muss hier entscheiden, ob man mit Aufsehen erregen die öffentliche Aufmerksamkeit - also zum Beispiel in den Medien - oder die Aufmerksamkeit innerhalb der wissenschaftlichen Community meint. Meiner Meinung nach hat wohl der sogenannte STAP-Fall besonders viel Aufmerksamkeit in den öffentlichen Medien gehabt. Der Fall hatte alle Zutaten für einen Hollywood-Film, ging leider aber auch mit dem tragischen Tod eines Wissenschaftlers einher.

Interessant an diesem Fall ist, dass Haruko Obokata, die im Zentrum des Skandals um gefälschte Daten in der Stammzellforschung stand, später angab, dass sie während ihres Studiums nie gelernt hätte, wie man wissenschaftliches Fehlverhalten meiden kann, wie man Bilder richtig zitiert, und dass es eben nicht in Ordnung ist, Daten aus früheren Publikationen einfach wiederzuverwenden.

Aber auch der Fall des südkoreanischen Stammzellforschers Woo-Suk Hwang wurde weltweit wahrgenommen und hat maßgeblich dazu beigetragen, dass viele Journale verstanden haben, wie wichtig es ist, beim Thema Bilder aufmerksam zu sein. Andererseits dringen andere Formen von Bildmanipulationen eher ins Bewusstsein der Öffentlichkeit. Man denke nur an die Fälle, die im Laufe der Zeit beim World-Press-Photo Award entdeckt wurden.

Wie gehen Wissenschaftler denn bei der Manipulation vor?

Thorsten Beck: Die Frage kann sehr unterschiedlich beantwortet werden, je nachdem ob eine Täuschungsabsicht vorliegt oder eben nicht. Nehmen wir den abstrakten Fall, dass jemand seine Forschung einfach besser aussehen lassen möchte und der Meinung ist, ein paar zusätzliche Bilder würden einen besseren Eindruck machen.

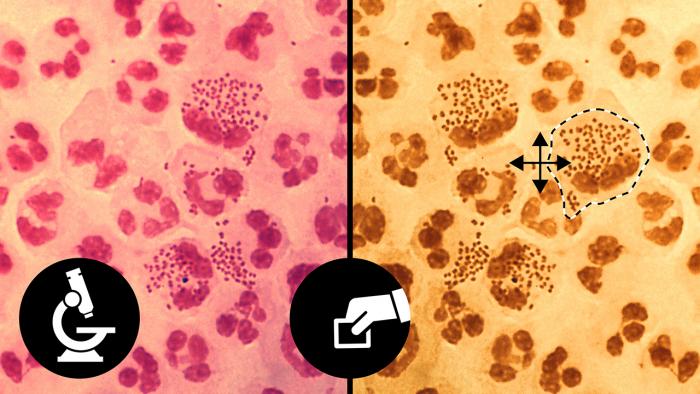

Wenn man diese Bilder nicht hat, dann kann man aus den existierenden Bildern neue Bilder produzieren, indem man andere Ausschnitte wählt oder in ein Bild hinein zoomt, es spiegelt oder die Helligkeit und den Kontrast verändert, um das Bild visuell vom Quellbild zu unterscheiden. Je mehr verschiedene Operationen zum Einsatz kommen, desto wahrscheinlicher ist es wohl, dass Absicht im Spiel war. Aber Photoshop und ähnliche Programme machen natürlich auch elaborierte Manipulationen möglich, die man weder mit dem bloßen Auge, noch mit Hilfe von Software erkennen kann. Dann werden Fälle manchmal zu einem forensischen Puzzlespiel.

Technische Lösungen sind erforderlich

Auf welche Art und Weise versucht man, automatisch die Manipulationen zu entdecken?

Thorsten Beck: Je nachdem, über welche Formen der Manipulation man spricht, gibt es sehr unterschiedliche Ansätze. Dabei berühren wir allerdings ein weiteres wissenschaftliches Spezialgebiet - die sogenannte Media- oder Computerforensik. Dort wird seit zwei Jahrzehnten daran geforscht, wie man Bildmanipulationen mit Hilfe von Algorithmen erkennen kann und wie man den Gerätetyp identifiziert, mit dem ein Bild produziert wurde.

Vielen Beteiligten ist inzwischen klar, dass wir es mit einer Herausforderung zu tun haben, die nicht mehr durch einzelne Akteure - etwa durch Bildanalysten - gelöst werden kann, sondern für die es technische Lösungen braucht. Am Anfang dieser Forschung standen Ansätze, bei denen es darum ging, Bildähnlichkeiten zu erkennen, etwa durch Vergleiche der Pixel. Ein Programm müsste dazu in der Lage sein, Bilder Pixel für Pixel abzutasten und Ähnlichkeiten entweder innerhalb eines Bildes oder zwischen zwei Bildern zu erkennen. Ein Problem solcher Analysen ist es, dass sie viel Rechenzeit in Anspruch nehmen. Auch können zum Beispiel Copy-Move-Manipulationen verschleiert werden, indem ein Unschärfefilter über das Bild gelegt wird. Es bleibt auch immer ein Hase-Igel-Spiel zwischen den Entwicklern forensischer Werkzeuge und jenen, die Manipulationen verschleiern wollen.

Welche Rolle spielt maschinelles Lernen dabei?

Thorsten Beck: Inzwischen werden Ansätze der Künstlichen Intelligenz und des maschinellen Lernens erprobt, bei denen sogenannte neuronale Netzwerke mit bestimmten Charakteristiken von Bildmanipulationen trainiert werden. Diese Ansätze - so wird es oft beschrieben - bilden dabei die Struktur des menschlichen Gehirns nach, daher der Begriff.

Ein immer wieder erwähntes Problem dieser Forschung ist es, dass es keine ausreichend großen Datenbanken mit Beispielen von Bildmanipulationen existieren, um solche Systeme zu füttern. Die bislang existierenden Datensätze sind meist nur ein paar tausend Bilder groß und in den meisten Fällen künstlich generiert. Um ausreichend viele Bilder zusammenzustellen, bräuchte es eine gemeinsame Anstrengung vieler wissenschaftlicher Akteure und Verlage. Bis also ein Durchbruch auf diesem Gebiet zu erwarten ist, bleibt es beim Status quo - man nimmt die Situation in Kauf oder investiert viel Zeit in manuelle Untersuchungen.

Wo sehen Sie die Vorteile und Nachteile der maschinellen Erkennung verglichen mit dem menschlichen Detektivgespür?

Thorsten Beck: Es braucht vielleicht noch nicht einmal menschliches Detektivgespür oder abstraktes Denken dafür, um die Unterschiede zwischen Maschine und Mensch hervorzuheben. Die besondere Kapazität, die ein menschlicher Gutachter mitbringt, ist der visuelle Kortex - quasi ein Hochleistungscomputer, der mit seinen Fähigkeiten immer noch einzigartig ist. Die zentralen Vorteile eines menschlichen Gutachters im Vergleich zur Maschine sind also Prozessorgeschwindigkeit, aber auch die Fähigkeit multiple Manipulationen erkennen zu können. Das kann noch keine Maschine und kein Algorithmus ähnlich gut wie ein trainierter Mensch.

Interessant wird es dort, wo Bildmanipulationen für das menschliche Auge unsichtbar bleiben oder schwer erkennbar sind - und die werden in Zukunft wohl immer mehr. Denken Sie nur an die Entwicklungen auf dem Bereich der Deep Fakes. Es lassen sich heute schon mühelos Videos produzieren, auf denen ein menschlicher Betrachter nicht mehr erkennen kann, ob es sich um eine wirkliche Person oder um das Ergebnis einer elaborierten Manipulation handelt. Gerade mit Blick auf die wachsende Bedeutung von sozialen Medien für die Informationslandschaft kann man sich leicht vorstellen, welche fatalen Folgen solche Instrumente haben können.

Aber auch Bildmanipulationen sind nicht immer leicht zu erkennen. Forschung hat gezeigt, dass untrainierte Probanden große Schwierigkeiten damit hatten, Manipulationen zu erkennen. Ein unbestrittener Vorteil der maschinellen Erkennung ist es, dass Maschinen keine Interessen verfolgen, sondern nur die Aufgabe, für die sie konstruiert sind. Das kann aber gefährlich sein - vor allem, wenn es um komplexe Entscheidungen geht, z.B. um den Umgang mit Fehlern. Deshalb werden auch in Zukunft immer Menschen eine wichtige Rolle bei der Beurteilung von Bildmanipulationen und möglichen Konsequenzen spielen.

"Eigentlich ist es nicht möglich, die Authentizität eines Bildes zu beweisen"

Kann man die Authentizität einer Abbildung überhaupt garantieren?

Thorsten Beck: Es fühlt sich ein bisschen an wie verkehrte Welt, wenn man über die Authentizität von Bildern spricht. Es ist richtig - eigentlich ist es nicht möglich, die Authentizität eines Bildes zu beweisen, sondern nur, dass es keinen Hinweis darauf gibt, dass es nicht authentisch ist. Man sucht im Zuge einer forensischen Analyse also nach Anhaltspunkten, die gegen die Integrität eines digitalen Bildes sprechen - und das ist ein weites Feld. Selbst wenn sich keinerlei Evidenzen ergeben, heißt das im Umkehrschluss noch lange nicht, dass ein Bild authentisch ist und dass es sich nicht doch um eine geschickt gemachte Manipulation handelt.

Da hat die digitale Bildforensik ja interessante Parallelen auch mit Fälschungen analoger Bilder. Denken Sie nur an den Fall des Kunstfälschers Beltracci oder an die Galileo-Fälschungen des Sternenboten durch Massimo De Caro. Gut gemachte Fälschungen können oft eben auch Experten täuschen, das gilt für digitale Bilder genauso wie für Gemälde, Zeichnungen, Skulpturen, Möbel…, die Liste ist endlos. Wer sich darum bemüht, die Authentizität eines Bildes zu beweisen, ist immer auch ein wenig in der Gefahr, Indizien zu übersehen. Eine wertneutrale Haltung ist da schon eher geeignet, die Indizien und Evidenzen nüchtern zu betrachten.

Nahm die Anzahl an Manipulationen in den letzten Jahren zu?

Thorsten Beck: Man muss zunächst feststellen, dass die Erkenntnisse über das genaue Ausmaß des Problems auf isolierten Studien, manueller Zählung und mancher Schätzung beruht. Da es keine zuverlässige automatisierte Erkennung von Bildmanipulationen gibt, beschränken sich die bekannten Fälle auf Forschung, die z.T. sehr unterschiedliche Aspekte betrachtet. Oft werden auch Selbstaussagen von WissenschaftlerInnen herangezogen, wenn es um wissenschaftliche Integrität geht, mitunter auf Stimmungsbilder, deren Aussagekraft dann wieder hinterfragt werden kann. Natürlich gibt es Phänomene, wie zum Beispiel die Produktion von fabrizierten Artikeln in sogenannten Paper-Mills, die es früher so nicht gab, aber man muss bei der Interpretation von Zahlen vorsichtig sein. Um von steigenden Zahlen ausgehen zu können, braucht es verlässliche Vergleichsgrößen.

Erfolgt die automatische Erkennung bisher im akademischen Versuchsbetrieb oder wenden Einrichtungen bzw. Firmen diese bereits produktiv an?

Thorsten Beck: Es gibt eine Reihe kommerzieller Anbieter auf dem Markt, die mit dem Versprechen locken, die Integrität von Bildern analysieren zu können. Man muss hier sicherlich differenzieren - je nachdem, welche Eigenschaften untersucht werden sollen. Es gibt ja sehr effektive Algorithmen, um die Ähnlichkeit von Bildern und von bestimmten Charakteristiken in Bildern zu identifizieren. Davon kann man sich schon bei der Google-Bildersuche überzeugen.

Komplizierter wird es, wenn eben mehr als ein Aspekt analysiert werden soll, wenn geklonte oder gelöschte Elemente identifiziert werden sollen oder wenn untersucht werden soll, ob ein Bild aus mehreren Bildern zusammengesetzt wurde. Insgesamt sollte man bei Heilsversprechen vorsichtig sein und genau hinsehen, was ein Produkt wirklich leisten kann.

Ein interessantes Experiment, das unter Umständen einen Durchbruch bringen könnte, ist das Projekt Assembler, bei dem Jigsaw und GoogleResearch in Kooperation mit namhaften Universitäten gemeinsam Werkzeuge entwickeln wollen, um den journalistischen Faktencheck zu erleichtern und um gegen Phänomene wie Bildmanipulation und Deep Fakes vorzugehen. Solche Schnittstellenprojekte zwischen Wissenschaft und Wirtschaft sind sicher interessant.

Treten Sie an Herausgeber wissenschaftlicher Zeitschriften heran, wenn sie auf manipulierte Bilder stießen?

Thorsten Beck: Nein - wir sind aber auch nicht auf der Suche nach manipulierten Bildern. In der Praxis werden problematische Artikel im Begutachtungsprozess gefunden oder auf Post-Publication-Plattformen wie PubPeer diskutiert. Es gibt auch eine Reihe von Wissenschaftlern, die zum Teil ehrenamtlich für Blogs wie Retraction Watch tätig sind und auf Probleme hinweisen. Es gab schon Fälle, bei denen wir um eine Einschätzung gebeten wurden, aber das sind Ausnahmen. Für solche Fälle gibt es in Deutschland ja das Ombudssystem und viele Universitäten haben ihre individuellen Ansprechpartner für konkrete Anliegen rund um wissenschaftliche Integrität.

Wäre es nicht ein Teil der Lösung und ein Beitrag zu Qualitätssicherung, wenn die den Abbildungen zugrunde liegenden Daten einsehbar wären?

Thorsten Beck: Darauf hatte schon Mike Rossner, damals als Chefredakteur der Zeitschrift Journal of Cell Biology in den frühen 2000er Jahren hingewiesen. Seine Empfehlung war einfach: Für jede Publikation sollen nicht nur die nachbearbeiteten Bilder, die für die Veröffentlichung vorgesehen sind, eingereicht werden, sondern auch die Originaldaten. Die Idee war, dass im Falle eines Verdachtes die Originaldaten eingesehen und verglichen werden könnten. Ob solch ein Workflow wirklich jedes wissenschaftliche Fehlverhalten verhindert bzw. dafür sorgt, dass alle Manipulationen aufgedeckt werden, kann ich nicht beurteilen. Mehr Information und Transparenz sind aber sicher kein falscher Ansatz. Inwieweit solche Maßnahmen aber von den Verlagen unterstützt werden, ist unklar.

"Beim Thema wissenschaftliche Integrität geht es nicht nur um technische Lösungen, sondern auch um klare Leitlinien dafür, was angemessen ist"

Das Humboldt Elsevier Advanced Data & Text Centre (HEADT), für das Sie tätig sind, stellt eine Kooperation der Humboldt Universität und des Verlages Elsevier dar. Wie ist diese ausgestaltet?

Thorsten Beck: Elsevier hat sich entschieden, das Thema wissenschaftliche Integrität nachhaltig zu fördern. Diese grundsätzliche Entscheidung war der Hintergrund, vor dem die Humboldt-Universität zu Berlin sich für eine Kooperation entschieden hat. Darüber hinaus gab es keine inhaltlichen Vorgaben von Seiten des Verlags. Das HEADT Centre macht also keine Auftragsforschung, aber es gibt natürlich dennoch immer wieder Gelegenheit für inhaltliche Zusammenarbeit. So hat Elsevier den Aufbau einer Datenbank für manipulierte Bilder gefördert oder wir haben Workshops und Webinare für die Researcher Academy von Elsevier angeboten. Das ist eine sehr gute Gelegenheit, um sehr viele Wissenschaftlerinnen und Wissenschaftler weltweit zu erreichen, für unsere Themen zu werben und die Diskussion zu suchen.

Sehen Sie den Einsatz der maschinellen Erkennungstechniken in Zukunft eher in den Händen der Hochschulen, vergleichbar zum Einsatz der Software zur Plagiatserkennung, oder als ein Element der Qualitätssicherung auf Seiten der Verlage bzw. Journale?

Thorsten Beck: Ich sehe das Interesse auf Seiten der wissenschaftlichen Verlage im Vordergrund, wenn es um eine automatisierte Erkennung von Bildmanipulationen geht. Für Verlage bedeutet jedes manipulierte Bild, das unerkannt veröffentlicht wird, einen nennenswerten Schaden und finanziellen Aufwand. Ein flächendeckendes Screening von allen veröffentlichten Bildern ist zeitaufwändig und teuer, genauso wie alle Anstrengungen, die mit einer Korrektur oder einer Retraction einher gehen. Dabei handelt es sich ja oft um jahrelange Prozesse, die nicht nur die Verlage, sondern auch die Universitäten und Forscherinnen und Forscher betreffen.

Ob und in welchem Ausmaß sich auch Universitäten dafür entscheiden würden, entsprechende Softwarelizenzen zu erwerben, lässt sich schwer sagen. Hier muss sicher auch noch Aufklärungsarbeit geleistet werden. Beim Thema wissenschaftliche Integrität geht es eben nicht nur um technische Lösungen, sondern vor allem auch um solide Ausbildung und klare Leitlinien dafür, was angemessen ist. Das haben viele Universitäten inzwischen aber auch erkannt und es wird versucht, die Lücken im Curriculum durch spezielle Angebote zu füllen. Hier ist auch das HEADT Centre aktiv. Wir entwickeln derzeit ein digitales Trainingsprogramm, durch das StudentInnen und WissenschaftlerInnen sich intensiv über ganz konkrete Fragestellungen rund um das Thema wissenschaftliche Integrität informieren können.

Den Betrügern dürfte nicht entgangen sein, dass die Forschung ihre Fälschungen aufdecken will. Verfeinern diese nun ihre Techniken? Wenn ja, auf welche Art und wie reagieren Sie und Ihre Kollegen darauf?

Thorsten Beck: Mir ist diese Argumentation vor allem aus der Literatur bekannt. Es wird immer wieder behauptet, dass die sogenannte Gegenforensik Mittel und Wege sucht, um forensische Werkzeuge zu unterlaufen. Aus der Praxis ist mir kein Beispiel dafür bekannt.

Ich sehe im Moment auch nicht, dass die Wissenschaft das wichtigste Spielfeld bei der Auseinandersetzung mit dem Thema Bildmanipulationen und Deep Fakes wäre. Der Informationskrieg, der auf sozialen Netzwerken und in der journalistischen Berichterstattung stattfindet, ist sicher der Inkubator für technische Entwicklungen, von denen dann später auch die Wissenschaft profitieren könnte. Neben dem schon erwähnten Beispiel von Google und Jigsaw hat auch Adobe seine Verantwortung erkannt und arbeitet an der Entwicklung von Instrumenten, die in der Lage sind, bestimmte Manipulationen sichtbar zu machen oder wieder zurück zu nehmen.

Für die Wissenschaft und das, was mit technischen Mitteln am Bild verändert werden kann, ist immer noch die Evolution der Bildbearbeitungsprogramme maßgeblich. Wir werden Betrüger nicht davon abhalten, weiter zu betrügen, wenn es ihnen einen Vorteil bringt. Unsere Angebote richten sich daher eher an die große Mehrheit der integren Forscherinnen und Forscher, die sich über angemessene Handlungsweisen informieren möchten. Es ist eben nicht nur wichtig, den Betrügern das Handwerk zu legen, sondern Klarheit darüber zu schaffen, was angemessen ist und wo die Grenzen verlaufen.