Die Aktualität von Asimovs Robotergesetzen

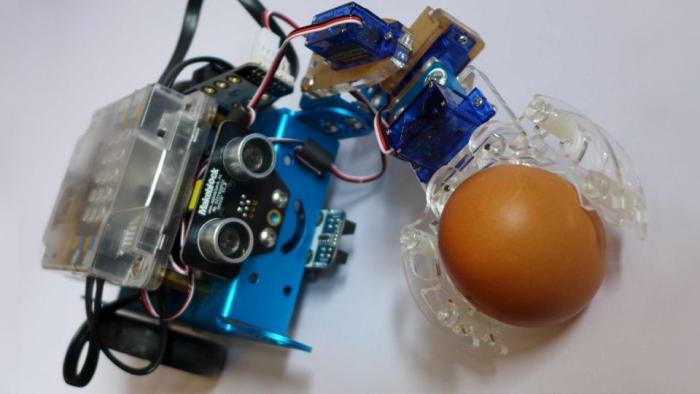

In Simulationen treten bei Robotern innere Zustände immer dann auf, wenn Katastrophen wie der eigene Totalausfall drohen

Die bekannten Robotergesetze von Isaac Asimov sind schon mehr als 75 Jahre alt. Systematisch untersucht wurden sie bislang nicht, obgleich durch die technische Entwicklung in der Computertechnik das Erstellen von Regeln für Roboter immer drängender wird: Autonome Fahrzeug fahren auf unseren Straßen, das EU-Parlament diskutiert Roboterrechte und nicht nur der Deutsche Ethikrat befasst sich mit Pflegerobotern.

Gunter Laßmann hat in seinem eBook Asimovs Robotergesetze philosophisch und technisch untersucht: Asimovs Robotergesetze. Was leisten sie wirklich?" Er erörtert, was ein Roboter ist und wie ein solcher Roboter nach dem heutigen Stand der Technik "denken" würde. Diskutiert wird, inwieweit Roboter individuell sein könnten und wer die Verantwortung für den Roboter trägt. Alle drei Robotergesetze werden erstmals simuliert, was teilweise zu unerwarteten Ergebnissen führt. Die Roboter werden durch Hinzunahme von Lernen weiterentwickelt, es werden die Unterschiede zwischen regelbasiertem Lernen und Deep Learning dargestellt und am aktuellen Beispiel erläutert.

Warum sind die Robotergesetze von Asimov so populär?

Gunter Laßmann: Sie sind einfach und auch für Menschen ohne Vorwissen sofort einsehbar. Außerdem befriedigen sie das Bedürfnis einen Schutz gegen die Maschinen zu haben. Viele sind sogar der Meinung, dass die Robotergesetze in den vorhandenen Robotern schon implementiert sind, was nicht stimmt. In der Langen Nacht der Wissenschaften 2017 an der TU Berlin, wo Teile des Buchs vorgestellt wurden, war der Saal brechend voll.

Wie aktuell sind Regeln für Roboter?

Gunter Laßmann: Das EU-Parlament hat sich mit Robotern beschäftigt, Pflegeroboter sollen den Pflegenotstand beheben und der ehemalige Verkehrsminister Dobrindt will beim Autonomen Fahren sogar Fahrer und Computer gleichstellen. Dies alles funktioniert nicht ohne Regeln für autonome Maschinen. Mehr Hype geht nicht.

Die Robotergesetze von Isaac Asimov sind schon mehr als 75 Jahre alt. Kann man da noch etwas für die heutige Zeit lernen?

Gunter Laßmann: Die Robotergesetze von Isaac Asimov sind eine literarische Konstruktion. Um sie anwenden zu können, müssen sie technisch und philosophisch seziert werden. Aber dann sind sie der Prototyp eines Systems von übergeordneten Regeln, von Metaregeln. Wir weisen nach, dass gerade die modernen selbstlernenden Systeme wie Deep Learning solche Metaregeln brauchen. Es kann nicht sein, dass z.B. der Chatbot "Tay" von Microsoft unter dem Einfluss der Nutzer innerhalb von 24 Stunden in ein rassistisches und sexistisches Propaganda-Programm mutiert. Hier sind übergeordnete Regeln erforderlich, die immer eingehalten werden.

Asimov war ein grenzenloser Optimist

Wo hat denn Asimov in seinen Prognosen wirklich falsch gelegen?

Gunter Laßmann: Asimov war bei der Einschätzung der Natur des Menschen ein grenzenloser Optimist. Terrorismus und so etwas wie Selbstmordanschläge konnte er sich damals nicht vorstellen. Aber heute, 2017, ist klar, dass ein Roboter auf keinen Fall die Befehle jedes beliebigen Menschen befolgen sollte, sondern nur die Befehle der dafür autorisierten Menschen. Andernfalls wäre es unverantwortlich, solche Roboter zu bauen.

Was würde denn Asimov zu der heutigen Diskussion um Roboter sagen?

Gunter Laßmann: Er würde sich wundern, dass es keinen Aufstand gegen die Übernahme von immer mehr Jobs in den Fabriken oder gegen teilautonome Waffen gibt. In seinen Roboter-Geschichten war der Einsatz von Robotern auf der Erde wegen der Furcht der Bevölkerung verboten. Asimov ging davon aus, dass sich der Einsatz von Roboter auf der Erde wegen der massiven Bedenken in der Bevölkerung nicht oder nur sehr langsam durchsetzen würde. An der relativ entspannten Haltung der Bevölkerung sind meiner Einschätzung nach die Robotergesetze nicht ganz unschuldig.

Gab in den 75 Jahren nicht schon andere Realisierungen der Robotergesetze?

Gunter Laßmann: 2014 simulierten Winfield, Blum und Lui mit kleinen dosenförmigen Robotern das erste und das dritte Robotergesetz. Sie untersuchten aber nicht die Wechselwirkungen in der Regelhierarchie wie wir.

Wird ein Roboter smarter, hört er weniger auf Befehle

Funktionieren denn die Robotergesetze in der Simulation? Werden denn alle gerettet?

Gunter Laßmann: Die Roboter retten erstaunlich viele. Es gibt aber Situationen, vergleichbar mit dem bekannten Trolley-Dilemma, da kann der Roboter nicht alle retten, egal, wie er sich entscheidet. Je mehr der Roboter rechnet, umso mehr kann er retten. Aber je mehr er unterwegs ist, um Schaden abzuwenden, umso weniger kommt er dazu, andere Befehle auszuführen. Wird ein Roboter smarter, hört er weniger auf Befehle.

Ist bei der Simulation etwas herausgekommen, was Sie überrascht hat?

Gunter Laßmann: Ich hatte als alter Asimov-Fan immer den Film "I Robot" abgelehnt, weil die Roboter dort Menschen töten, um andere Menschen zu retten. In unserer Simulation opfert der Roboter auch, um retten zu können. Der Film hat Recht.

Werden Roboter einmal so etwas wie Gefühle haben?

Gunter Laßmann: Die Roboter in unserer Simulation könnten, da ihnen mehrstufige Bewertungen von Situationen vorliegen, sehr glaubhaft Gefühle darstellen. Außerdem funktionieren wir Menschen so, dass wir in Roboter sowieso Gefühle hineininterpretieren. In den Simulationen haben wir in den Robotern innere Zustände entdeckt, die immer dann auftreten, wenn dem Roboter Katastrophen, wie der eigene Totalausfall, drohen. Diese inneren Zustände hindern den Roboter daran, Entscheidungen zu treffen, etwa so, wie Angst Menschen blockieren kann.

Warnung vor "Deep Learning"

In ihrem Buch warnen Sie vehement vor dem Einsatz selbstlernender Verfahren wie "Deep Learning", warum?

Gunter Laßmann: Es gibt zwei Hauptprobleme beim Deep Learning. Erstens gibt es keine Kontrollmöglichkeit über das, was das System wirklich gelernt hat. Zweitens können bei Aufnahme neue Daten alte Erkenntnisse verloren gehen. Damit sind technische Abnahmen von Deep Learning Systemen eigentlich nicht möglich.

Wird ein Autonomes Fahrzeug durch Deep Learning trainiert, kann es also sein, dass es lernt, z.B. wegen kleiner Jungs in Matrosenanzügen nicht zu bremsen. So etwas ist durchaus plausibel, wenn z.B. während des Trainings überall Plakatwände mit Jungs in Matrosenanzügen vorhanden waren. Um einen solchen Fehler zu bemerken, müssen erst einige Unfälle mit kleinen Jungs in Matrosenanzügen passieren. Wird dann ein Datensatz zur Vermeidung solcher Unfälle eintrainiert, wird damit die Gesamtmenge des Gelernten erhöht. Da aber die Gesamtmenge des Gelernten begrenzt ist, kann durch diese zusätzliche Lektion etwas Nützliches vergessen werden. Hoffentlich bremst dann das System weiter auch für kleine Mädchen mit roter Schleife.

Wann werden Maschinen intelligenter sein als Menschen?

Gunter Laßmann: Einen feststehenden Intelligenzquotienten für eine Person halte ich für eine Fiktion mit schlimmen Folgen. Als ob die Menschen mit einer Zahl auf der Stirn herumlaufen würden! Ich selbst bin zum Beispiel direkt nach dem Aufstehen extrem unintelligent. Intelligenz abstrakt als "die Fähigkeit, Probleme lösen zu können" zu betrachten, macht dagegen Sinn. Denn jeder hat auf verschiedenen Problemfeldern unterschiedlich gute Fähigkeiten Probleme zu lösen. Und die Zahl der Probleme, die auch Maschinen lösen können, steigt.

Wie intelligent sind denn ihre simulierten Asimov-Roboter?

Gunter Laßmann: Diese Roboter bekommen keine direkten Anweisungen und kennen nur die Robotergesetze. Trotzdem lösen sie komplexe logistische Aufgaben und finden oft sogar die mathematisch optimale Lösung. Mein siebenjähriger Enkel fand diese Lösungen auch, er machte aber hinterher einige Verbesserungsvorschläge.

Wann kommen die Roboter?

Gunter Laßmann: Der Aufwand einen Roboter zu bauen, wurde zu Asimovs Zeiten massiv unterschätzt. Aber technische Fortschritt mit Miniaturisierung und Verbilligung der Bauteile gleicht dies zunehmend aus. Trotzdem wird es den "klassischen Roboter", wie ihn Asimov beschreibt, wahrscheinlich nie geben, denn die Kommunikationsmöglichkeiten sind heute wesentlich ausgeprägter, als sich das die damaligen Autoren vorstellen konnten und vor allem das Internet stellt eine neue Größe dar, die so nicht erwartet wurde. Besonders die Möglichkeit große Datenmengen in der Cloud speichern oder sogar wesentliche Rechenschritte dorthin auszulagern, wird sich wesentlich auf die Konstruktion moderner Roboter auswirken.

Wann sind solche modernen Roboter Bestandteil des täglichen Lebens?

Gunter Laßmann: Sind einige moderne Roboter nicht vielleicht schon da? Laufen nicht überall Smartphone-plus- Mensch-Cyborgs herum, die nicht mehr funktionieren, wenn sie getrennt werden?

Aber der Begriff "Roboter" kommt ja vom körperlichen Arbeiten, wer macht denn bei diesen Cyborgs die Arbeit ?

Gunter Laßmann: Richtig, in der Science Fiction sind die Roboter die "blue-collar"Fraktion, die die DDD="Dull, Dirty and Dangerous"-Arbeiten macht. Aber das ist Science-Fiction, wenn die Maschinen da sind, sieht das anders aus.

Auf der Tagung über Pflegeroboter bei den Soziologen an der TU Berlin kam heraus, dass die eigentlichen Pflegeaufgaben wie Wasserreichen, Saubermachen, Verbände wechseln usw. für Roboter noch viel zu schwierig sind. Aber die leichten Aufgaben wie Smalltalk und Bespaßen können die Maschinen. Da müssen die Menschen aufpassen, dass für sie nicht nur die DDD-Aufgaben bleiben.