Neuer Job für künftige Quantencomputer

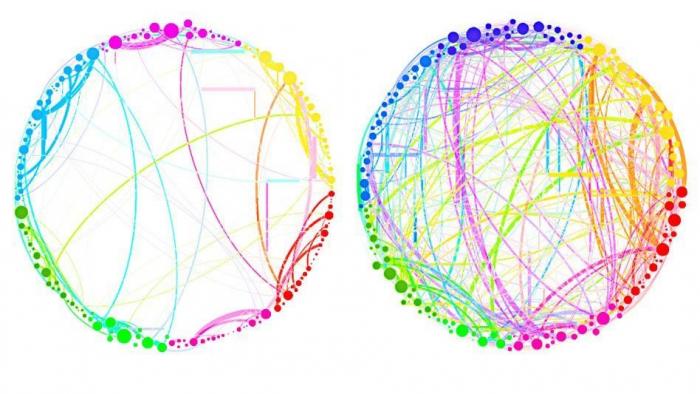

Grafische Darstellung der Verbindungen zwischen Hirnregionen: Das linke Bild zeigt die Verbindungen bei einem nüchternen Probanden, das rechte Bild zeigt die eines Probanden unter Einfluss des psychedelischen Psilocybin. Die vermehrten Verbindungen erklären durch die Droge hervorgerufene Wahrnehmungsveränderungen wie das "Hören" von Farben oder das "Sehen" von Gerüchen. Die umfassende Analyse solcher Daten müsste Milliarden von Gehirnzellen umfassen, was für derzeitige Computer zu komplex ist, mit künftigen Quantencomputern aber laut US-Forschern möglich sein soll. Bild: MIT

Physiker entwickeln Verfahren für die Analyse von Datenmengen, die zu groß für herkömmliche Computertechnik sind

Ein Computer, der alle anderen in Sachen Rechentempo und Speicherkapazität abhängt, soll er werden, der Quantencomputer. Es gibt nur ein Problem: Bislang sind kaum Anwendungen bekannt, bei denen diese in Entwicklung befindliche Technologie ihre potenziellen Vorteile auch tatsächlich wird ausspielen können. Physiker stellen oft in Aussicht, ein Quantencomputer würde gigantische Datenmengen wie sie etwa in der Hirnforschung anfallen, sehr viel schneller auswerten als es selbst die leistungsstärksten Supercomputer vermögen.

Das sei reine Spekulation, entgegnen andere. Denn Quantencomputer benötigen eigens für sie entwickelte Rechenverfahren, auch Quantenalgorithmen genannt. Diese gibt es bislang nur für wenige Aufgaben, etwa für das Knacken von heute täglich genutzten Verschlüsselungsverfahren, aber kaum für Big-Data-Anwendungen.

Nun hat ein Team um den Quantenphysiker Seth Lloyd vom Massachusetts Institute of Technology (MIT) in Boston einen Quantenalgorithmus vorgestellt, der in unübersichtlichen Datenmengen nach bestimmten Mustern fahndet. Muster, die interessant für die Forschung sein könnten, die Analyse von Sozialen Netzwerken oder des weltweiten Warentransports. Damit erhält die Vision vom Quantencomputer als Big-Data-Anwendung neue Nahrung. Auch das so genannte maschinelle Lernen soll durch beschleunigte Datenanalysen verbessert werden, sodass Computer nach kurzem Training selbständig Autos, Vögel oder andere Objekte auf Bildern erkennen. Das ist einer der Gründe, warum der Suchmaschinenprimus Google Millionensummen in die Entwicklung von Quantencomputern investiert.

Dass diese neue Art von Rechner überhaupt so schnell sein soll, liegt an einer Fähigkeit atomarer und subatomarer Teilchen, die man ansonsten nur einigen Heiligen zuspricht: Sie können sich an mehreren Orten gleichzeitig aufhalten. Und nicht nur das: Simultan links und rechts herum rotieren, mehrere Geschwindigkeiten gleichzeitig - lauter leichte Übungen für Atome, Elektronen oder Lichtteilchen. Daher sind die winzigen Teilchen auch den Speicherzellen klassischer Computer überlegen. Diese speichern ein Bit, das entweder den Wert 0 oder den Wert 1 annehmen kann. Ein subatomares Teilchen hingegen speichert die beiden Werte simultan und kann auch beide Werte gleichzeitig verarbeiten. Es nennt sich daher Quantenbit, kurz Qubit.

Mehrere Qubits zusammen erreichen eine unfassbare Rechen- und Speicherkapazität. Denn sie wechselwirken miteinander, sodass jedes hinzukommende Qubit die Zahl der speicherbaren Werte verdoppelt. Zwei Qubits nehmen vier Werte simultan auf, drei Qubits acht Werte, vier Qubits sechzehn etc. Schon einige Hundert Qubits können theoretisch mehr Werte gleichzeitig speichern und verarbeiten als es Elementarteilchen im Universum gibt.

Zum Tragen kommt dieser Vorteil aber nur für bestimmte Fragestellungen, was daran liegt, dass die Qubits zwar viele mögliche Antworten simultan speichern sowie verarbeiten können, am Ende des Rechenprozesses aber nur die eine richtige übrigbleiben darf. Dafür müssen sich während des Vorganges die falschen Lösungswege auf ähnliche Weise gegenseitig auslöschen wie sich Wellen neutralisieren, wenn Wellenberge auf -täler treffen. Nur wenn es gelingt, für die konkrete Aufgabe ein Verfahren zu finden, das die richtige Antwort am Ende herausfiltert, gelingt die rasante Rechnung.

Der Quantenalgorithmus von Seth Lloyd und Kollegen erfüllt diese Anforderung. Er sucht nach so genannten globalen Eigenschaften von großen Datenmengen. Diese charakterisieren den Datensatz als Ganzes, so wie sich z.B. ein Soziales Netzwerk durch die Anzahl der Verbindungen unter seinen Mitgliedern oder der Zahl der Mitglieder mit mehr als 100 Freunden beschreiben lässt.

Die grafische Darstellung eines solchen Netzwerkes enthält Löcher oder, wenn es dreidimensional ist, Höhlen. Sogar "Hohlräume" mit noch viel mehr Dimensionen ergeben sich bei entsprechender Strukturierung der Daten. Die Anzahl von solchen Höhlen ist ebenfalls eine globale Eigenschaft.

Die Beziehungen unter den Elementen einer Menge können sehr komplex und vielgestaltig sein, wie die Abbildung oben zeigt, die Verknüpfung von Hirnregionen darstellt. Mit jedem zusätzlichen Element in der Menge - jedem neuen Mitglied im Sozialen Netzwerk oder jeder neuen Hirnregion - verdoppelt sich der Aufwand, die globalen Eigenschaften zu bestimmen. Daher haben klassische Computer bei sehr großen Datenmengen keine Chance in einer überschaubaren Zeit zum Ergebnis zu kommen. Lloyds Quantenalgorithmus hingegen benötigt nicht mehr Rechenschritte als ein Computer für arithmetische Operationen wie Multiplikation oder Division benötigt. Denn er nutzt geschickt die Fähigkeit des Quantencomputers, die Daten simultan zu verarbeiten. Wenn die Datenmenge zunimmt steigt der Rechenaufwand zwar an, läuft aber nicht aus dem Ruder, ähnlich wie die Multiplikation einer riesigen Zahl zwar etwas länger dauert, aber abwartbar bleibt.

Ein Quantencomputer mit 300 Qubits sei für diese Leistung ausreichend, meint Seth Lloyd. In letzter Zeit nimmt der Zuversicht unter Quantenphysikern zu, dass ein Quantencomputer dieser Größe schon innerhalb des kommenden Jahrzehnts einsatzfähig sein könnte. Es gibt aber auch Skeptiker, die meinen das könne noch 50 Jahre oder länger dauern. Manche Physiker bezweifeln, dass Quantencomputer überhaupt je funktionieren werden, weil sie von den kleinsten Umwelteinflüssen empfindlich gestört werden. Ob die sich dabei ergebenden Rechenfehler schnell genug korrigiert werden können, wird derzeit intensiv erforscht.

Skeptisch zeigt sich auch der theoretische Informatiker Scott Aaronson vom MIT, der die Einsatzmöglichkeiten von Quantencomputern untersucht und darüber bloggt. "Es bleibt unklar, ob der neue Quantenalgorithmus schnell genug arbeitet, um von wirklich praktischem Nutzen zu sein." Das wird sich erst zeigen, wenn die oft so genannte "Wundermaschine" tatsächlich einsatzbereit ist.