Vorhersageungleichheit bei Fußgängererkennung von autonomen Fahrzeugen

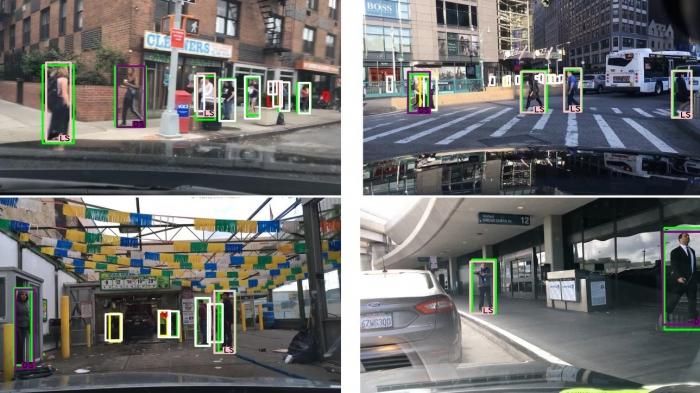

BIld: Benjamin Wilso, Judy Hoffman, Jamie Morgenstern: Predictive Inequity in Object Detection

Personen mit dunkler Hautfarbe werden von den Programmen schlechter erkannt, was die Unfallhäufigkeit für bestimmte Gruppen erhöhen könnte

Im Januar war bekannt geworden, dass das Gesichtserkennungsprogramm Rekognition von Amazon, die auch von Polizei- und Einwanderungsbehörden eingesetzt wird, Probleme mit dunkelhäutigen Menschen hat. Wissenschaftler unter Leitung von Joy Buolamwini vom MIT Media Lab waren darauf gestoßen, dass es zu Schwierigkeiten kam bei der Erkennung des Geschlechts. Nicht nur wurden Frauen allgemein schlechter erkannt und mit Männern verwechselt, sondern vor allem dunkelhäutigere Frauen.

Das war der Bürgerrechtsorganisation ACLU schon bei einem Test mit Politikerbildern im Sommer 2018 aufgefallen. Buolamini hatte im Jahr zuvor ähnliche Probleme bei Programmen von Microsoft, IBM und Megvii festgestellt, die seit dem aber offenbar korrigiert wurden. Auch bei anderen Programmen wurden rassistische oder geschlechtliche Neigungen deutlich, beispielsweise bei Programmen zur Vorhersage, ob Straftäter wieder rückfällig werden.

Tödlicher Unfall

Problematisch kann die Sehschwäche der Künstlichen Intelligenz werden, die mitunter auch als algorithmischer Rassismus oder mangelnde algorithmische Fairness bezeichnet wird, wenn sie etwa für autonome Fahrzeuge zur Erkennung von Fußgängern eingesetzt wird. Vorurteile und blinde Flecken können hier schnell tödlich enden, wenn Personen nicht als solche erkannt oder mit etwas anderem verwechselt werden.

Letztes Jahr wurde bekannt, dass ein autonomes Über-Fahrzeug, deren Fahrerin abgelenkt war, eine Frau auf einem Highway in Tempe überfahren und getötet hatte, die abends um 22 Uhr in dunkler Kleidung mit einem Fahrrad über die Straße lief (Der Unfall von Uber). Das KI-System des Fahrzeugs, das mit einer Geschwindigkeit von 69 km/h fuhr, leitete erst in letzter Sekunde eine Notbremsung ein, die aber deaktiviert war. Zuvor hatte das System Schwierigkeiten, die Frau zu erkennen. Sie wurde zunächst als unbekanntes Objekt, dann als Fahrzeug und schließlich als Fahrrad eingestuft, nicht erkannt wurde auch, in welche Richtung die Frau lief. Kurzfristig war daraufhin das Vertrauen der Menschen in autonome Fahrzeuge eingebrochen und hatte Uber sein Programm in Arizona pausieren lassen. Uber wurde für den tödlichen Unfall strafrechtlich nicht belangt.

Dunkelhäutige Menschen sind von Vorhersageungleichheit betroffen

Wissenschaftler vom Georgia Institute of Technology haben aufgrund der Hinweise auf fehlerhafte Erkennung wegen der Hautfarbe mehrere Objekterkennungssysteme, die für autonome Fahrzeuge verwendet werden, mit der Hilfe der großen Bilddatenbank für Fußhänger untersucht. Getestet wurde das Verhalten der Systeme mit Fußgängern, die nach den sechs Hauttypen von Fitzpatrick in zwei Gruppen (1-3 von sehr hell bis mittel und 4-6 von bräunlich bis schwarz) eingeteilt wurden.

Menschen der Gruppe 4-6 wurden schlechter erkannt, unabhängig von der Tageszeit oder dem Verdeckungsgrad durch andere Gegenstände, aber auch vom Programm, schreiben sie in ihrer Studie, die sie auf arxiv.org veröffentlicht haben. Die nicht erfreuliche Schlussfolgerung der Wissenschaftler: "Dieses Verhalten legt nahe, dass künftige Fehler, die von autonomen Fahrzeugen gemacht werden, nicht gleichmäßig über verschiedene demografische Gruppen verteilt sind." Das heißt, dunkelhäutigere oder schwarze Menschen hätten womöglich ein höheres Unfallrisiko, wenn autonome Fahrzeuge die Straßen übernehmen. Das könnte auch bei ethischen Dilemmata eine Rolle spielen, also ob ein autonomes Fahrzeug rechts oder links ausweicht.

Die Wissenschaftler gingen nicht den ethischen Problemen, sondern nur der Vorhersageungleichheit (predictive inequality) nach, die sie quantifizieren wollten. Nachdem sie Programm, Tages- bzw. Nachtzeit und Verdeckungsgrad als maßgebliche Größen ausschließen konnten, auch wenn die Größe der Personen und der Grad von deren Verdecktheit die Genauigkeit vermindert, blieb als eine der Ursachen für die Vorhersageungleichheit für Menschen mit dunklerer Hautfarbe von 5 Prozent wenig überraschend das Datenset übrig.

In dem zum Maschinenlernen verwendeten Bilderset waren deutlich mehr Aufnahmen von hellen (Fitzpatrick 1-3) als von dunklen (4-6) Personen. Die Vorhersageungleichheit verschwand durch die höhere Gewichtung der Bilder von dunklen Personen. Die Wissenschaftler machen darauf aufmerksam, dass sich hinter dem oft bemerkten Problem, das KI-Programm an zu wenigen Daten zu schulen, zwei unterschiedliche und unabhängige Phänomene verbergen können: aus kleinen Datensets kann sich eine geringere statistische Gewissheit ergeben, sie können aber auch beim Lernen eine geringere Bedeutung erlangen.

Das Problem liegt hier also nicht an den Verfahren des Maschinenlernens, sondern an der Auswahl der Daten, mit denen die Programme gefüttert werden. Ein Nebeneffekt der Vorurteile, die bei KI-Systemen auftauchen, könnte eben sein, die Aufmerksamkeit auf die Zusammenstellung der Datensets zu schärfen, die von menschlichen Vorurteilen oder zu geringer Beachtung von Minderheiten geprägt sein können.