Alles ist relativ

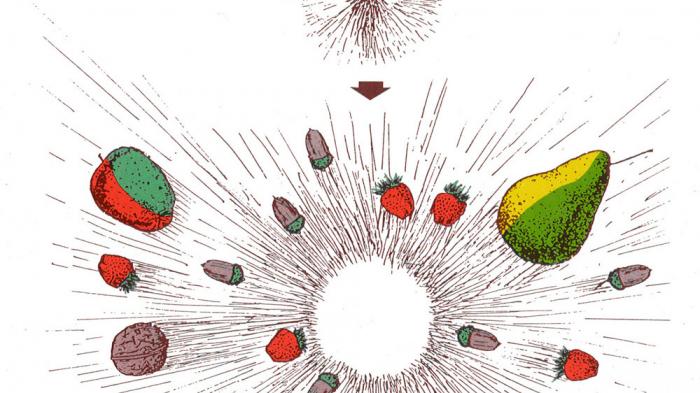

Titelbild der CERN-Broschüre: "How energy becomes matter ...", 1983. Die elementaren Quanten entsprechen wohl eher den unteilbaren Atomen Demokrits, als die Atomkerne. Interessanterweise hat sich die Bezeichnung "Quant" nur für das Photon in der Namensalternative "Lichtquant" erhalten, alle anderen werden leider als Elementarteilchen bezeichnet. Wenn zwei Elementarteilchen in einem Beschleuniger wie dem CERN aufeinander treffen, entstehen neue Quanten, die aber nicht die Bestandteile der aufeinander geschossenen Quanten sind. Wären Erdbeeren in diesem Sinne elementar, würde ihr hochenergetischer Zusammenprall neue Erdbeeren und alle möglichen anderen Elementarfrüchte erzeugen. Wiedergabe mit freundlicher Genehmigung des CERN.

Eine kleine Geschichte der Physik der Elementarteilchen

Diese dreiteilige Serie untersucht Aspekte populärer Physikkritik. Im ersten Teil wird eine kurze Geschichte der modernen Physik skizziert, insbesondere der der Elementarteilchen. Sie dient den beiden folgenden Teilen als Referenz. Der zweite Teil beschäftigt sich mit spezifischen Kritikpunkten, exemplarisch mit den Thesen Alexander Unzickers, der in den letzten beiden Jahren zwei vielgelesene Polemiken zum Status der gegenwärtigen Physik verfasst hat. Im letzten Teil wird die Verwendung von wissenschaftstheoretischen Ansichten, insbesondere denen von Thomas S. Kuhn - "Paradigmenwechsel" - und Paul Feyerabend - "anything goes" - behandelt, deren Hypothesen bei Wissenschaftskritikern äußerst populär sind und die sich beide im Wesentlichen mit der Geschichte der Physik beschäftigten.

Seitdem das World Wide Web allgemein verfügbar ist, dient es nicht zuletzt Wissenschaftsskeptikern zur Verbreitung ihrer kruden Thesen. Ob Gegner der Relativitätstheorie, Feinde der Darwinschen Evolutionslehre oder Leute, für die die Mondlandungen ein einziger Schwindel waren, sie alle nutzen paradoxerweise ein Medium, das ein Kind der modernen Physik ist, deren Aussagen sie oft so vehement bekämpfen.

Das WWW entstand beim CERN vor inzwischen mehr als zwanzig Jahren bei dem Versuch, die Kommunikation zwischen den Mitgliedern der damals immer größer werdenden internationalen Kollaborationen zu vereinfachen. Die moderne Physik, vor allem die Elementarteilchenphysik, fasziniert und polarisiert gleichermaßen. Als das CERN im Juni diesen Jahres verkündete, ein Teilchen sei gefunden worden, das mit dem lange gesuchten Higgs-Boson identisch sein könnte, erfuhr diese Meldung in allen Leitmedien starke Resonanz. Der Spiegel titelte überschwänglich, ein Tor zu einer neuen Welt sei aufgestoßen worden. Gleichzeitig werden die Kontroversen innerhalb der Physik und der Astronomie vom allgemeinen Publikum ebenfalls mit Spannung verfolgt. Vor zwei Jahren wurde sogar das polemische Buch "Vom Urknall zum Durchknall" des Physiklehrers Alexander Unzicker zum "Wissenschaftsbuch des Jahres" ernannt.

Im Vergleich zur Aufmerksamkeit, die physikalische Theorienbildung und Praxis durch Wissenschaftstheoretiker und Philosophen erfahren, werden andere Naturwissenschaften weitgehend vernachlässigt. Daher ist es berechtigt und dem allgemeinen Interesse förderlich, sich auf die Physik zu konzentrieren. Wer sich als Wissenschaftstheoretiker oder populärer Kritiker mit der Physik auseinandersetzt, entwickelt seine Gedanken quasi zwangsläufig anhand der geschichtlichen Entwicklung der Physik, die selbstverständlich höchst individuell gefärbt wiedergegeben wird. In dieser Serie ist die Physik ausschließlich als fundamentalstes Instrument von Naturerkenntnis von Interesse. Hier, aus dieser Perspektive, eine Skizze zentraler Elemente der Physikgeschichte.

Perfektes Timing - das Ende der klassischen Physik

Als Zeitraum, in dem die Physik begann, sich von der Philosophie zu lösen, können die Jahre um 1620 genommen werden, als Galileo Galilei zu der Überzeugung gelangte, das Buch der Natur sei in der Sprache der Mathematik verfasst. Ernsthafte Physik kann nicht ohne Mathematik betrieben werden, während Formeln in philosophischen Texten die absolute Ausnahme bilden. 1686 legte Isaac Newton sein physikalisches Hauptwerk vor, "Philosophiae Naturalis Principia Mathematica", dessen Titel die Mathematik sogar im Titel führt. In der Principia legte Newton die Grundlagen der Mechanik und definierte sein Gravitationsgesetz.

Mathematik alleine reicht allerdings nicht aus, die Physik zu begründen. Die zweite Säule ist die Empirie durch systematisches Beobachten und Experimentieren, deren Grundgerüst ebenfalls von Galilei errichtet wurde. Newton seinerseits steuerte bahnbrechende experimentelle Befunde bei, nicht zuletzt in der Optik die Aufspaltung von weißem Licht in die Farben des Regenbogens mit Hilfe eines Prismas. Theoretische und Experimentalphysik sind bis auf den heutigen Tag die beiden zusammengehörenden Teile der Physik.

Exakt bis zum Jahr 1900 erstreckte sich die Zeit der heute als "klassisch" bezeichneten Physik. In jenem Jahr sah sich Max Planck dazu gezwungen, zur Erklärung der elektromagnetischen Strahlung eines glühenden Körpers diskrete Energiequanten einzuführen, die mit der bis dahin entwickelten kontinuierlichen Physik nicht beschreibbar waren.

Zweihundert Jahre klassische Physik

In den zweihundert Jahren nach Newton hatte sich die Physik mit wachsendem Tempo weiter entwickelt. Die mathematischen Methoden wurden wesentlich verbessert, die Wärmelehre bildete sich heraus und entwickelte sich zur Thermodynamik weiter, elektrische und magnetische Phänomene wurden systematisch untersucht. Zudem entstand die Chemie als neue naturwissenschaftliche Disziplin, die immer wieder Rückwirkungen auf die Physik hatte.

Die zweite Hälfte des 19ten Jahrhunderts war besonders reich an neuen Erkenntnissen. Zwei Paukenschläge gab es allein in den 1860er Jahren: Die Deutung des Lichts als elektromagnetische Welle und die Entdeckung des Periodensystems der Elemente. James Clerk Maxwell vereinigte in den heute nach ihm benannten Gleichungen die Elektrizität mit dem Magnetismus und deutete Licht als elektromagnetische Welle. Dmitri Mendelejew gelang es, die Elemente anhand ihrer chemischen Eigenschaften und ihrer Atomgewichte in einem Periodensystem zu ordnen. Aufgrund von Lücken in seinem System leitete er die Existenz von bis dahin unbekannten Elementen ab. Sein Selbstbewusstsein ist bemerkenswert, denn er konnte nur aufgrund seines Ordnungsprinzips argumentieren; der uns heute bekannte Aufbau eines Atoms aus Kern und Elektronenhülle, war ihm noch völlig unbekannt.

Kurz vor der Jahrhundertwende erschien die Welt der Physik im Wesentlichen als so gut wie erforscht. Natürlich gab es offene Probleme und sogar einen Grundkonflikt mit der Chemie. John Dalton hatte Anfang des 19. Jahrhunderts seine Atomtheorie entwickelt und damit die moderne Chemie begründet. Die Physiker taten sich aber schwer mit der Vorstellung, die Natur sei aus diskreten, unteilbaren Bestandteilen zusammengesetzt. Ihre Differentialgleichungen, nicht zuletzt die gerade erst von Maxwell entdeckten, beschrieben eine kontinuierliche Welt. Max Planck war einer der Atomskeptiker. Allerdings gab es mit der kinetischen Gastheorie auch eine Erklärung von physikalischen Eigenschaften wie dem Gasdruck aufgrund von Wechselwirkungen zwischen angenommenen kleinsten Teilchen. Wäre die Skepsis unter den Physikern weniger ausgeprägt gewesen, wären die Grundlagen der Quantenmechanik vielleicht deutlich früher entdeckt worden- wer weiß.

Äther und Glühbirne, die beiden Totengräber der klassischen Physik

Zwei völlig unterschiedliche Probleme sollten die Physik letztendlich in Schwierigkeit bringen. Das erste war grundlegender Natur. Wenn Licht eine Welle ist, benötigt es ein Ausbreitungsmedium. Dass Licht mit Materie wechselwirkt, war offensichtlich. In Glas bewegt es sich langsamer als in Luft, so kommt die Lichtbrechung zustande. Wie kann es sich aber im Vakuum ausbreiten? Warum, simpel gefragt, können wir die Sonne überhaupt sehen?

Als Lichtmedium wurde die Existenz des Äthers postuliert, der das Vakuum des Weltalls ausfüllen sollte. Ein an sich nicht unübliches Vorgehen. Auch Mendelejew hatte trotz fehlender Elemente nicht sein Periodensystem verworfen, sondern die Existenz neuer Elemente behauptet. Der Äther jedoch war von Anfang an ein ausgesprochen seltsames Gebilde. Erstens wurde er nur für das Vakuum wirklich benötigt. Zweitens durfte er nur mit elektromagnetischen Wellen wechselwirken, nicht jedoch mit Materie. Denn wenn er, beispielsweise, bei den Planeten auf ihren Bahnen um die Sonne Reibung verursacht hätte, wie waren dann überhaupt stabile Planetenbahnen möglich und wieso ließen diese sich mit Newtons Gravitationsgesetz beschreiben, in dem gar keine Ätherreibung vorkam? Irgendetwas Grundsätzliches stimmte nicht.

Das zweite Problem erschien zunächst als ein rein praktisches. Seit Beginn der industriellen Revolution wurde für die Arbeit unter Tage und in den Fabriken nach neuen Lichtquellen gesucht, die sicherer als eine Kerzenflamme waren, zuverlässiger und heller. Schon Anfang des 19. Jahrhunderts wurde entdeckt, dass Leiter anfangen zu glühen, wenn sie von starken Strömen durchflossen werden. Seitdem wurde versucht, eine zuverlässige Glühlampe zu entwickeln. Erst der um 1880 aufkommenden Kohlefaserlampe Thomas Alva Edinsons gelang der allgemeine Durchbruch.

Nun ging es um die Frage, genau zu verstehen, wie das Lichtspektrum einer Glühlampe physikalisch erzeugt wird, um den Wirkungsgrad von Lampen optimieren und die Lichtqualität steuern zu können. Mit der elektromagnetischen Theorie und der Thermodynamik schienen die Physiker über die idealen Werkzeuge zu verfügen, diese anwendungsorientierte Fragestellung zu lösen. Eine grandiose Fehleinschätzung! Dieses herausragende Beispiel sollten sich heutzutage all diejenigen vor Augen führen, die vehement die Meinung vertreten, Grundlagenforschung sei sekundär. In jeder anwendungsorientierten Aufgabenstellung kann ein grundlegendes, fundamentales Problem schlummern.

Um die Intensitäten des Spektrums von glühenden Körpern zu messen, mussten zunächst neue experimentelle Verfahren entwickelt werden. Ein vollkommen schwarzer Körper reflektiert kein Licht. Wenn er farbig erscheint, wird dies alleine von seiner Temperatur verursacht. An ihm kann die Lichterzeugung durch Wärme also störungsfrei gemessen werden. Ein genialer Trick war es, einen fast idealen Schwarzen Körper durch einen Hohlraum zu emulieren, also eine beheizte Box, in die kein Licht fallen kann. Die Intensitäten der Strahlung wird durch ein möglichst kleines Loch gemessen. Parallel dazu wurde die Strahlung theoretisch berechnet. Das Ergebnis war die "Utraviolettkatastrophe": Bei kurzen Wellenlängen lieferte die Maxwellsche Theorie utopisch hohe Werte.

Raten und Verzweifeln

Durch seinen mathematischen Sachverstand gelang es Max Planck, die gemessenen Strahlungsintensitäten mit einer Gleichung zu beschreiben, zunächst ohne für sie eine physikalische Herleitung vorweisen zu können. Zudem musste er eine neue physikalische Konstante einführen, die heute als Plancksches Wirkungsquantum h bekannt ist. Viel schwieriger als das Aufstellen der Formel erwies sich ihre physikalische Herleitung. 1900 war Planck bereits 42 Jahre alt und in der kontinuierlichen Physiktradition verhaftet. Er konnte seine Spektralformel aber nur herleiten, wenn er annahm, dass das Licht in diskreten Portionen, Quanten, ausgesandt wurde. Er musste sogar auf atomistischen Verfahren Ludwig Boltzmanns zurückgreifen. Dies bezeichnete er später selbst als einen "Akt der Verzweiflung"1.

Plancks Analyse deckte erste Risse auf im bis dahin vorherrschenden physikalischen Weltbild. Fünf Jahre später, in seinem "Wunderjahr", gab Albert Einstein mit vier Veröffentlichungen und seiner Dissertation der kompletten Physik ein neues Fundament. Er löste damit den Konflikt mit der Chemie und das noch verbleibende Problem der Lichtausbreitung im Vakuum. Von da an beschäftigte sich die Physik mit Atomen, Quanten und verfügte über ein grundlegend neues Raum-Zeit-Verständnis. Allgemein berühmt ist Einstein für seine spezielle Relativitätstheorie (SRT), die zwei der Arbeiten ausmacht. Wirklich revolutionär jedoch, auch nach Einsteins eigener Einschätzung, war seine Veröffentlichung über den photoelektrischen Effekt. Für diese erhielt er später dann auch den Nobelpreis.

Ein Wunderjahr und anschließend 25 Jahre Herumirren

Beim Photoeffekt, hier in einer stark vereinfachten Version beschrieben, werden Elektronen aus einem Metall durch das Auftreffen von Licht freigesetzt. Um ein Elektron aus dem Metall zu lösen, ist eine bestimmte Energie nötig. Rotes Licht ist energieärmer, als blaues. Aber wenn die Anzahl der herausgelösten Elektronen nur von der eingestrahlten Gesamtenergie abhängt, wie mit gesundem Menschenverstand zu vermuten ist, sollte rotes Licht hoher Intensität ebenso viele Elektronen herauslösen können, wie weniger intensives blaues Licht. Das war jedoch nicht der Fall. Nur blaues Licht setzte Elektronen frei.

Einstein konnte dieses Verhalten erklären, indem er Plancks Quantenhypothese verallgemeinerte. Bei Planck gab eine Glühlampe zwar diskrete elektromagnetische Impulse ab, das elektromagnetische Feld an sich konnte jedoch weiterhin als kontinuierliche Welle verstanden werden. Enstein fasste das Feld nun selbst als aus Lichtquanten, Photonen, aufgebaut auf und jedes Photon hatte eine Energie h*f, wobei f seine Frequenz ist. Dies ist die Beziehung, auf die Planck fünf Jahre zuvor schon gestoßen war. Nur blaue Photonen mit ihrer hohen Frequenz haben somit genug Energie, Elektronen auszulösen. Intensives rotes Licht hingegen erwärmte das Metall nur.

Einsteins Erklärung war wahrhaft revolutionär, denn sie warf gleich mehrere vorherrschende Überzeugungen über den Haufen. Aus dem kontinuierlichen elektromagnetischen Feld machte sie eine Ansammlung von Teilchen, deren Energie mit einer Welleneigenschaft beschrieben wurde. Die erste Ausprägung des Welle-Teilchen-Dualismus war entdeckt. Da Teilchen kein Ausbreitungsmedium benötigen, wird auch verständlich, wieso sich Licht im Vakuum ausbreiten kann. Der Äther ist überflüssig. Elektromagnetismus kommt zustande, indem geladene Teilchen untereinander ungeladene Photonen austauschten.

Hatte die Physik bis dahin meistens versucht, möglichst einfache Ein- oder Zweiteilchenprobleme zu beschreiben oder statistische Aussagen wie in der Gastheorie zu treffen, so verwandelten sich auf einmal selbst ehemals relativ einfache Fälle in Vielteilchenprobleme. Das war nicht wirklich ermutigend, denn schon das vermeintlich überschaubare Dreikörperproblem der Gravitationstheorie Newtons hatte sich als nur numerisch lösbar erwiesen. Einsteins Analyse bedeutete jedoch, dass die neue Physik selbst für winzigste Zeitintervalle die Verarbeitung von Aberbilliarden zu erzeugenden und zu absorbierenden Teilchen bewältigen musste. Für die Erklärung des Photoeffekts verwendete Einstein statistische Methoden der Thermodynamik, um zu zeigen, dass sich Photonen unter bestimmten Umständen wie ein Gas aus unabhängigen Teilchen verhalten. Aber wie konnten die Details der Wechselwirkung zwischen zwei Ladungen beschrieben werden?

Ein weiteres Problem gab es noch. Ein Indiz für die Existenz des Äthers war gewesen, dass die Maxwellschen Gleichungen sozusagen automatisch die Vakuumlichtgeschwindigkeit enthielten - und zwar als eine Konstante. Wie konnte dieser Befund mit den Photonen in Übereinstimmung gebracht werden, die keinen Äther benötigen? In seiner Arbeit: "Zur Elektrodynamik bewegter Körper", entwickelte Einstein hierfür die SRT, die spezielle Relativitätstheorie.

Schallwellen breiten sich im Medium Luft ebenfalls mit einer ganz bestimmten Geschwindigkeit aus, wenn Bedingungen wie Luftdruck und -temperatur konstant gehalten werden. Wenn sich ein Beobachter in der Atmosphäre bewegt, so bewegen sich die von ihm ausgehenden Schallwellen im Medium Luft immer nur mit Schallgeschwindigkeit, was er messen kann. Auf ähnliche Weise müsste der Effekt der Bewegung der Erde durch den Äther gemessen werden können, so die Annahme.

Effekte eines Ätherwindes wurden jedoch nicht gefunden, in Übereinstimmungen mit den Maxwell-Gleichungen. Elektromagnetische Wellen breiten sich für jeden gleichmäßig bewegten Beobachter immer so aus, als wenn der Beobachter im Äther ruhe. Zudem sollte der Äther unveränderlich sein, denn die Vakuumlichtgeschwindigkeit c ist eine universelle Konstante, anders als die Schallgeschwindigkeit, die vom physikalischen Zustand der Luft abhängt. Die Situation ist ähnlich zu der im Innern eines Festkörpers, in dem sich Wellen ausbreiten.

Einstein erkannte, dass die Konstanz der Lichtgeschwindigkeit nicht einfach ein elektromagnetisches Phänomen ist, sondern ein fundamentales Prinzip, das für alle Arten von Wechselwirkungen, also auch die Gravitation, gelten muss. Die beiden Grundaussagen der SRT sind schnell aufgeführt. Erstens sind alle unbeschleunigten Bezugssysteme gleichberechtigt. Es gibt kein Bezugssystem, das eine besondere Bedeutung hätte. Zweitens leben wir in einem Universum, in dem es eine Maximalgeschwindigkeit c gibt, mit der Energie und Information transportiert werden können. Es gibt kein Bezugssystem, in dem diese Geschwindigkeit übertroffen werden kann. Photonen bewegen sich nur deshalb mit dieser Geschwindigkeit, weil sie keine Ruhemasse haben.

Einsteins Arbeiten von 1905 zeigten in den Grundzügen, wie ein Elektromagnetismus jenseits von Maxwell beschrieben werden konnte. Elektrische Ladungen senden Unmengen ungeladener Photonen aus und fangen sie wieder auf. Dadurch entstehen die Wechselwirkungskräfte. Da die Photonen sich mit Lichtgeschwindigkeit bewegen, muss eine solche Quantentheorie des Lichts grundsätzlich relativistisch sein, selbst für Situationen, in denen die Geschwindigkeiten der Ladungen viel kleiner sind, als die Lichtgeschwindigkeit. Genau dies ist es, was die Mutter aller modernen physikalischen Theorien, die Quantenelektrodynamik, die QED, heute ausmacht.

Interessanterweise wurde 1905 dieser Ansatz aber nicht verfolgt. 25 Jahre sollte es dauern, bis die Physiker endlich daran gingen, zu versuchen, das längst Erkannte in Formeln zu fassen. Einstein selbst begab sich nach seinem Wunderjahr auf seinen außerordentlichen Egotrip, die Gravitation zu verstehen. Was ihm zehn Jahre später tatsächlich gelang und wenig später endgültig berühmt machte. Der Rest der Physikgemeinde rang weiterhin damit, den immer noch ungeliebten Atomismus zu verdauen. Und sie redeten sich ein, die SRT sei zwar gültig, aber müsse erst berücksichtigt werden, wenn die studierten Teilchen sich mit Geschwindigkeiten bewegten, die der Lichtgeschwindigkeit nahe kommen. Diese Position wird auch heute noch gerne vertreten, obwohl sie viel zu kurz greift. Tatsächlich kann nicht einmal ein ruhendes, einzelnes Elektron ohne die SRT vernünftig beschrieben werden.

Alles ist relativ, wirklich alles

Der Grund dafür ist der interne Drehimpuls von Elektronen und Protonen. Dieser Spin wurde Mitte der 1920er Jahre entdeckt und erklärte bestimmte, bis dahin nicht erklärbare Eigenschaften von Spektrallinien. Der Spin ist eine Quanteneigenschaft, d.h. es sind nur bestimmte Werte physikalisch möglich, aber keine Zwischenwerte. Zudem hat ein Elementarteilchen immer einen ganz bestimmten, charakteristischen Gesamtspin. Anders als bei einem klassischen Drehimpuls, beispielsweise dem einer rotierenden Kugel, kann der Spin eines Teilchens nicht vergrößert oder verkleinert werden: Elementarteilchen rotieren sozusagen immer gleich schnell.

Wolfgang Pauli hatte kurz zuvor seine Auswahlregel postuliert, dass zwei Elektronen in einem Atom nicht dieselben Quantenzahlen haben können. Nur so ließ sich der Aufbau der Elektronenhülle und somit die beobachteten Spektren verstehen. Daher können sich zum Beispiel in der ersten Schale maximal zwei Elektronen aufhalten, die sich nur in der Orientierung ihres Spins unterscheiden. Dies gilt für alle Atome, egal, wie viele (positive) Protonen sich im Kern befinden. Der Aufbau der Elektronenhülle bestimmt die chemischen Eigenschaften der Elemente, da chemische Bindungen durch den Austausch von Elektronen zwischen den Atomen zustande kommen.

Wenig später wurde erkannt, dass die Auswahlregel ein Spezialfall ist. Elektronen und Protonen haben einen Spin, der halb so groß ist wie der von Photonen, die einen Spin Eins haben. Teilchen mit halbzahligem Spin werden heute als Fermionen bezeichnet, Teilchen mit ganzzahligem Spin als Bosonen. Alle Fermionen verhalten sich so, wie von Pauli für Elektronen postuliert. Bosonen verhalten sich eher so, wie man es von klassischen Teilchen erwarten würde; für sie gilt die Auswahlregel nicht. Hier enthüllte sich eine fundamentale Zweiteilung der Welt: Fermionen machen das aus, was wir als Materie bezeichnen, wohingegen Bosonen wie das Photon die Wechselwirkungen zwischen den Fermionen vermitteln.

Die Entdeckung des Spins der Elementarteilchen bedeutete aber nicht zu verstehen, wieso sie überhaupt einen unveränderlichen, gequantelten inneren Drehimpuls haben. Die Lösung dieses neuen Problems ergab sich ganz unerwartet, fast von alleine. P.A.M. Dirac hatte sich gefragt, wie eine quantenmechanische Grundgleichung für das Elektron aussehen müsste, die der SRT genügt und möglichst allgemein ist.2 Schließlich stellte er eine Gleichung auf, die seine Forderungen erfüllte, jedoch zwei besondere Eigenschaften besaß. Erstens beinhaltete sie den Elektronenspin, ohne dass zu Beginn ihrer Herleitung der Spin als besondere Eigenschaft hätte berücksichtigt werden müssen. Zweitens beschrieb Diracs Gleichung kein einzelnes Elektron, sondern zwei, eines davon mit der seltsamen Eigenschaft, eine negative Energie zu haben. Dieses seltsame Teilchen wurde als Positron gedeutet, als erster bekannter Vertreter der Antimaterie. Tatsächlich wurde es wenig später entdeckt.

Spin und die Existenz von Antimaterie lassen sich also zwanglos durch die SRT erklären. Somit auch der Aufbau der Atomhülle und somit die Chemie. Die SRT beschreibt universelle physikalische Eigenschaften von Raum und Zeit, deren Wirkungen sich nicht erst bei Geschwindigkeiten nahe der Lichtgeschwindigkeit zeigen. 1940 gelang es Wolfgang Pauli zudem, die seltsame Aufteilung der Welt in Fermionen und Bosonen durch sein Spin-Statistik-Theorem allgemein mit Hilfe der relativistischen Quantenfeldtheorie herzuleiten.

Fazit

Die physikalische Welt, wie wir sie heute verstehen, ist grundsätzlich relativistisch. Dies gilt für die Gravitation genau so, wie für die anderen beiden bekannten Wechselwirkungen, die elektroschwache und die starke Wechselwirkung. Letztere werden durch das Standardmodell der Elementarteilchen beschrieben, in dem relativistische Quantenfeldtheorien verwendet werden.

Andere berühmte Gleichungen, die auch heute noch nicht selten als Grundgleichungen bezeichnet werden, ganz besonders die Schrödinger-Gleichung, sind nur Näherungen, die zum Zeitpunkt ihrer Erstellung legitim zu sein schienen, weil sich relativistische Effekte erst bei hohen Geschwindigkeiten zeigen sollten. Es wäre an der Zeit, diese Tatsache in Erinnerung zu rufen.